引言:电商运营者面临的数据获取困境

在竞争激烈的电商市场中,每一个成功的卖家都深知一个道理:数据就是生命线。当您在深夜时分,看着竞争对手的产品销量节节攀升,而自己的listing却门可罗雀时,您是否想过这样的问题:

- 为什么同样的产品,别人的关键词排名总是比我高?

- 竞争对手到底在哪些关键词上投入了广告预算?

- 市场上新兴的搜索趋势我该如何第一时间捕获?

- 如何批量分析数千个关键词的搜索表现和竞争态势?

传统的手工数据收集方式早已无法满足现代电商运营的需求。当您需要分析数万个关键词时,靠人工逐一搜索不仅效率低下,更会错过瞬息万变的市场机会。这就是为什么越来越多的专业卖家和工具开发商开始寻求Amazon关键词数据采集API解决方案的根本原因。

传统数据获取方式的局限性分析

手工采集的弊端

许多电商从业者仍在使用最原始的数据收集方法:打开浏览器,逐个搜索关键词,手动记录搜索结果。这种方式存在诸多问题:

效率问题:一个人一天最多能手工采集几十个关键词数据,而专业的市场分析往往需要处理数万个关键词。按照这个速度,完成一次全面的市场调研可能需要数月时间,到那时市场情况早已发生翻天覆地的变化。

准确性问题:Amazon的搜索结果会根据用户的地理位置、搜索历史、设备类型等因素进行个性化调整。手工采集无法控制这些变量,导致数据缺乏标准化,不同时间、不同环境下采集的数据难以进行横向对比。

时效性问题:电商市场瞬息万变,特别是在促销季、新品发布期间,关键词的搜索量和竞争态势可能每小时都在变化。手工采集的数据往往已经过时,无法支撑实时决策。

现有工具的不足

市面上虽然存在一些数据分析工具,但大多存在以下问题:

数据深度不足:许多工具只能提供基础的搜索量数据,无法获取广告投放情况、商品排名变化、价格波动等深层次信息。

成本高昂:知名工具的API服务价格往往让中小卖家望而却步,而且通常会限制每月的调用次数,难以满足大规模数据分析需求。

更新频率低:部分工具的数据更新频率较低,可能一天只更新一次,无法满足需要实时监控的场景。

覆盖范围有限:很多工具只覆盖热门关键词,对于长尾关键词的数据采集能力有限,而长尾关键词往往蕴含着巨大的商业机会。

Amazon关键词数据的商业价值深度解析

搜索趋势洞察

亚马逊关键词爬取工具能够帮助我们发现市场的微妙变化。例如,在疫情期间,”home office”相关关键词的搜索量激增,敏锐的卖家通过数据分析提前布局相关产品,获得了巨大的市场先机。

通过持续监控关键词搜索量的变化,我们可以:

- 提前发现新兴市场趋势

- 识别季节性需求波动

- 捕获突发事件带来的需求变化

- 分析消费者行为模式的演变

竞争对手情报

Amazon搜索数据API接口可以帮助我们深入了解竞争对手的营销策略:

广告投放分析:通过分析搜索结果页面的广告位分布,我们可以了解竞争对手在哪些关键词上投入了广告预算,广告文案的优化方向,以及投放时间规律。

产品定位策略:观察竞争对手的产品在不同关键词下的排名表现,可以推断出他们的SEO策略和产品定位思路。

价格策略分析:通过监控竞争对手在不同关键词搜索结果中的价格变化,可以预测其价格调整策略,从而制定相应的应对措施。

产品优化指导

关键词数据不仅能帮助我们了解市场和竞争对手,更重要的是能指导我们优化自己的产品:

listing优化:通过分析高转化率关键词的特征,优化产品标题、描述和关键词标签。

广告投放优化:识别高ROI的关键词组合,优化广告投放策略,降低获客成本。

新品开发方向:通过分析搜索量高但竞争相对较小的关键词,发现新的产品机会。

技术实现方案:从环境搭建到数据采集

环境准备

在开始实时亚马逊数据抓取之前,我们需要搭建合适的开发环境。

Python环境配置

# 安装必要的依赖包

pip install requests pandas numpy beautifulsoup4 lxml

pip install schedule # 用于任务调度

pip install sqlite3 # 用于本地数据存储

项目结构设计

amazon_keyword_scraper/

├── config/

│ ├── __init__.py

│ └── settings.py # 配置文件

├── src/

│ ├── __init__.py

│ ├── scraper.py # 核心采集模块

│ ├── parser.py # 数据解析模块

│ ├── storage.py # 数据存储模块

│ └── scheduler.py # 任务调度模块

├── data/

│ ├── keywords.csv # 关键词列表

│ └── results/ # 采集结果

├── logs/ # 日志文件

└── main.py # 主程序入口

基础数据采集实现

1. 配置文件设置

# config/settings.py

import os

class Config:

# Pangolin API配置

PANGOLIN_API_URL = "https://scrapeapi.pangolinfo.com/api/v1/scrape"

PANGOLIN_TOKEN = os.getenv('PANGOLIN_TOKEN', 'your_token_here')

# 采集参数配置

DEFAULT_ZIPCODE = "10041" # 默认邮区

CONCURRENT_REQUESTS = 5 # 并发请求数

REQUEST_DELAY = 2 # 请求间隔(秒)

# 数据存储配置

DATABASE_PATH = "data/keywords_data.db"

CSV_OUTPUT_PATH = "data/results/"

# 日志配置

LOG_LEVEL = "INFO"

LOG_FILE = "logs/scraper.log"

2. 核心采集模块

# src/scraper.py

import requests

import time

import logging

from typing import List, Dict, Optional

from config.settings import Config

class AmazonKeywordScraper:

def __init__(self):

self.config = Config()

self.session = requests.Session()

self.session.headers.update({

"Authorization": f"Bearer {self.config.PANGOLIN_TOKEN}",

"Content-Type": "application/json"

})

def scrape_keyword_data(self, keyword: str, zipcode: str = None) -> Optional[Dict]:

"""

采集单个关键词的搜索结果数据

"""

if not zipcode:

zipcode = self.config.DEFAULT_ZIPCODE

# 构建Amazon搜索URL

search_url = f"https://www.amazon.com/s?k={keyword.replace(' ', '+')}"

payload = {

"url": search_url,

"formats": ["json"],

"parserName": "amzKeyword",

"bizContext": {"zipcode": zipcode}

}

try:

response = self.session.post(

self.config.PANGOLIN_API_URL,

json=payload,

timeout=30

)

if response.status_code == 200:

result = response.json()

if result.get('code') == 0:

return self._process_keyword_data(result['data'], keyword)

else:

logging.error(f"API返回错误: {result.get('message')}")

return None

else:

logging.error(f"HTTP请求失败: {response.status_code}")

return None

except Exception as e:

logging.error(f"采集关键词 {keyword} 时发生异常: {str(e)}")

return None

def _process_keyword_data(self, raw_data: Dict, keyword: str) -> Dict:

"""

处理原始数据,提取关键信息

"""

processed_data = {

'keyword': keyword,

'timestamp': int(time.time()),

'total_results': 0,

'products': [],

'sponsored_ads': [],

'price_range': {'min': 0, 'max': 0},

'top_brands': [],

'avg_rating': 0

}

products = raw_data.get('products', [])

processed_data['total_results'] = len(products)

if products:

# 提取产品信息

prices = []

ratings = []

brands = []

for product in products:

product_info = {

'asin': product.get('asin'),

'title': product.get('title'),

'price': self._parse_price(product.get('price')),

'rating': product.get('star', 0),

'review_count': product.get('rating', 0),

'image_url': product.get('image'),

'is_sponsored': 'sponsored' in product.get('title', '').lower()

}

processed_data['products'].append(product_info)

# 统计数据

if product_info['price'] > 0:

prices.append(product_info['price'])

if product_info['rating'] > 0:

ratings.append(product_info['rating'])

# 识别广告产品

if product_info['is_sponsored']:

processed_data['sponsored_ads'].append(product_info)

# 计算统计信息

if prices:

processed_data['price_range']['min'] = min(prices)

processed_data['price_range']['max'] = max(prices)

if ratings:

processed_data['avg_rating'] = sum(ratings) / len(ratings)

return processed_data

def _parse_price(self, price_str: str) -> float:

"""

解析价格字符串,返回数值

"""

if not price_str:

return 0.0

# 移除货币符号和非数字字符

import re

price_match = re.search(r'[\d,]+\.?\d*', price_str.replace(',', ''))

if price_match:

return float(price_match.group())

return 0.0

def batch_scrape_keywords(self, keywords: List[str], zipcode: str = None) -> List[Dict]:

"""

批量采集关键词数据

"""

results = []

for i, keyword in enumerate(keywords):

logging.info(f"正在采集关键词 {i+1}/{len(keywords)}: {keyword}")

data = self.scrape_keyword_data(keyword, zipcode)

if data:

results.append(data)

# 控制请求频率

if i < len(keywords) - 1:

time.sleep(self.config.REQUEST_DELAY)

return results

3. 数据存储模块

# src/storage.py

import sqlite3

import pandas as pd

import json

from datetime import datetime

from typing import List, Dict

from config.settings import Config

class DataStorage:

def __init__(self):

self.config = Config()

self.init_database()

def init_database(self):

"""

初始化数据库表结构

"""

conn = sqlite3.connect(self.config.DATABASE_PATH)

cursor = conn.cursor()

# 创建关键词数据表

cursor.execute('''

CREATE TABLE IF NOT EXISTS keyword_data (

id INTEGER PRIMARY KEY AUTOINCREMENT,

keyword TEXT NOT NULL,

timestamp INTEGER NOT NULL,

total_results INTEGER DEFAULT 0,

avg_rating REAL DEFAULT 0,

min_price REAL DEFAULT 0,

max_price REAL DEFAULT 0,

sponsored_count INTEGER DEFAULT 0,

data_json TEXT,

created_at DATETIME DEFAULT CURRENT_TIMESTAMP

)

''')

# 创建产品数据表

cursor.execute('''

CREATE TABLE IF NOT EXISTS product_data (

id INTEGER PRIMARY KEY AUTOINCREMENT,

keyword TEXT NOT NULL,

asin TEXT NOT NULL,

title TEXT,

price REAL DEFAULT 0,

rating REAL DEFAULT 0,

review_count INTEGER DEFAULT 0,

is_sponsored BOOLEAN DEFAULT 0,

timestamp INTEGER NOT NULL,

created_at DATETIME DEFAULT CURRENT_TIMESTAMP

)

''')

conn.commit()

conn.close()

def save_keyword_data(self, data: Dict):

"""

保存关键词数据到数据库

"""

conn = sqlite3.connect(self.config.DATABASE_PATH)

cursor = conn.cursor()

# 保存关键词汇总数据

cursor.execute('''

INSERT INTO keyword_data

(keyword, timestamp, total_results, avg_rating, min_price, max_price, sponsored_count, data_json)

VALUES (?, ?, ?, ?, ?, ?, ?, ?)

''', (

data['keyword'],

data['timestamp'],

data['total_results'],

data['avg_rating'],

data['price_range']['min'],

data['price_range']['max'],

len(data['sponsored_ads']),

json.dumps(data)

))

# 保存产品详细数据

for product in data['products']:

cursor.execute('''

INSERT INTO product_data

(keyword, asin, title, price, rating, review_count, is_sponsored, timestamp)

VALUES (?, ?, ?, ?, ?, ?, ?, ?)

''', (

data['keyword'],

product['asin'],

product['title'],

product['price'],

product['rating'],

product['review_count'],

product['is_sponsored'],

data['timestamp']

))

conn.commit()

conn.close()

def export_to_csv(self, keywords: List[str] = None, date_range: tuple = None) -> str:

"""

导出数据为CSV格式

"""

conn = sqlite3.connect(self.config.DATABASE_PATH)

# 构建查询条件

where_conditions = []

params = []

if keywords:

placeholders = ','.join(['?' for _ in keywords])

where_conditions.append(f"keyword IN ({placeholders})")

params.extend(keywords)

if date_range:

where_conditions.append("timestamp BETWEEN ? AND ?")

params.extend(date_range)

where_clause = " WHERE " + " AND ".join(where_conditions) if where_conditions else ""

# 查询数据

query = f'''

SELECT

keyword,

datetime(timestamp, 'unixepoch') as search_time,

total_results,

avg_rating,

min_price,

max_price,

sponsored_count

FROM keyword_data

{where_clause}

ORDER BY timestamp DESC

'''

df = pd.read_sql_query(query, conn, params=params)

# 生成文件名

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

filename = f"{self.config.CSV_OUTPUT_PATH}keyword_analysis_{timestamp}.csv"

df.to_csv(filename, index=False, encoding='utf-8-sig')

conn.close()

return filename

高级功能实现

1. 智能调度系统

# src/scheduler.py

import schedule

import threading

import time

from datetime import datetime, timedelta

from typing import List, Callable

from src.scraper import AmazonKeywordScraper

from src.storage import DataStorage

class KeywordScheduler:

def __init__(self):

self.scraper = AmazonKeywordScraper()

self.storage = DataStorage()

self.running = False

self.thread = None

def add_keyword_job(self, keywords: List[str], interval_minutes: int, zipcode: str = None):

"""

添加定时采集任务

"""

def job_function():

try:

logging.info(f"开始执行定时采集任务: {len(keywords)} 个关键词")

results = self.scraper.batch_scrape_keywords(keywords, zipcode)

# 保存结果

for result in results:

self.storage.save_keyword_data(result)

logging.info(f"定时采集任务完成,共采集 {len(results)} 个关键词")

except Exception as e:

logging.error(f"定时采集任务执行失败: {str(e)}")

schedule.every(interval_minutes).minutes.do(job_function)

logging.info(f"已添加定时任务:每 {interval_minutes} 分钟采集 {len(keywords)} 个关键词")

def start(self):

"""

启动调度器

"""

if self.running:

return

self.running = True

self.thread = threading.Thread(target=self._run_scheduler)

self.thread.daemon = True

self.thread.start()

logging.info("关键词采集调度器已启动")

def stop(self):

"""

停止调度器

"""

self.running = False

if self.thread:

self.thread.join()

logging.info("关键词采集调度器已停止")

def _run_scheduler(self):

"""

运行调度循环

"""

while self.running:

schedule.run_pending()

time.sleep(1)

2. 数据分析模块

# src/analyzer.py

import pandas as pd

import numpy as np

from typing import Dict, List, Tuple

from src.storage import DataStorage

class KeywordAnalyzer:

def __init__(self):

self.storage = DataStorage()

def analyze_keyword_trends(self, keyword: str, days: int = 7) -> Dict:

"""

分析关键词趋势

"""

import sqlite3

from datetime import datetime, timedelta

end_time = int(datetime.now().timestamp())

start_time = int((datetime.now() - timedelta(days=days)).timestamp())

conn = sqlite3.connect(self.storage.config.DATABASE_PATH)

query = '''

SELECT

datetime(timestamp, 'unixepoch') as date,

total_results,

avg_rating,

min_price,

max_price,

sponsored_count

FROM keyword_data

WHERE keyword = ? AND timestamp BETWEEN ? AND ?

ORDER BY timestamp ASC

'''

df = pd.read_sql_query(query, conn, params=[keyword, start_time, end_time])

conn.close()

if df.empty:

return {'error': 'No data found for the specified keyword and time range'}

# 计算趋势指标

analysis_result = {

'keyword': keyword,

'period': f'{days} days',

'data_points': len(df),

'trends': {

'total_results': {

'current': df['total_results'].iloc[-1] if not df.empty else 0,

'average': df['total_results'].mean(),

'trend': self._calculate_trend(df['total_results'].values)

},

'avg_rating': {

'current': df['avg_rating'].iloc[-1] if not df.empty else 0,

'average': df['avg_rating'].mean(),

'trend': self._calculate_trend(df['avg_rating'].values)

},

'price_range': {

'min_current': df['min_price'].iloc[-1] if not df.empty else 0,

'max_current': df['max_price'].iloc[-1] if not df.empty else 0,

'min_trend': self._calculate_trend(df['min_price'].values),

'max_trend': self._calculate_trend(df['max_price'].values)

},

'sponsored_ads': {

'current': df['sponsored_count'].iloc[-1] if not df.empty else 0,

'average': df['sponsored_count'].mean(),

'trend': self._calculate_trend(df['sponsored_count'].values)

}

}

}

return analysis_result

def _calculate_trend(self, values: np.array) -> str:

"""

计算数据趋势

"""

if len(values) < 2:

return 'insufficient_data'

# 使用线性回归计算趋势

x = np.arange(len(values))

slope, _ = np.polyfit(x, values, 1)

if slope > 0.1:

return 'increasing'

elif slope < -0.1:

return 'decreasing'

else:

return 'stable'

def compare_keywords(self, keywords: List[str]) -> Dict:

"""

比较多个关键词的表现

"""

import sqlite3

conn = sqlite3.connect(self.storage.config.DATABASE_PATH)

comparison_data = {}

for keyword in keywords:

query = '''

SELECT

AVG(total_results) as avg_results,

AVG(avg_rating) as avg_rating,

AVG(min_price) as avg_min_price,

AVG(max_price) as avg_max_price,

AVG(sponsored_count) as avg_sponsored

FROM keyword_data

WHERE keyword = ?

AND timestamp > (strftime('%s', 'now') - 7*24*3600)

'''

result = conn.execute(query, [keyword]).fetchone()

comparison_data[keyword] = {

'avg_results': result[0] or 0,

'avg_rating': result[1] or 0,

'avg_min_price': result[2] or 0,

'avg_max_price': result[3] or 0,

'avg_sponsored': result[4] or 0

}

conn.close()

# 计算排名

rankings = {}

for metric in ['avg_results', 'avg_rating', 'avg_sponsored']:

sorted_keywords = sorted(keywords,

key=lambda k: comparison_data[k][metric],

reverse=True)

rankings[metric] = {kw: idx+1 for idx, kw in enumerate(sorted_keywords)}

return {

'comparison_data': comparison_data,

'rankings': rankings,

'analysis_date': datetime.now().isoformat()

}

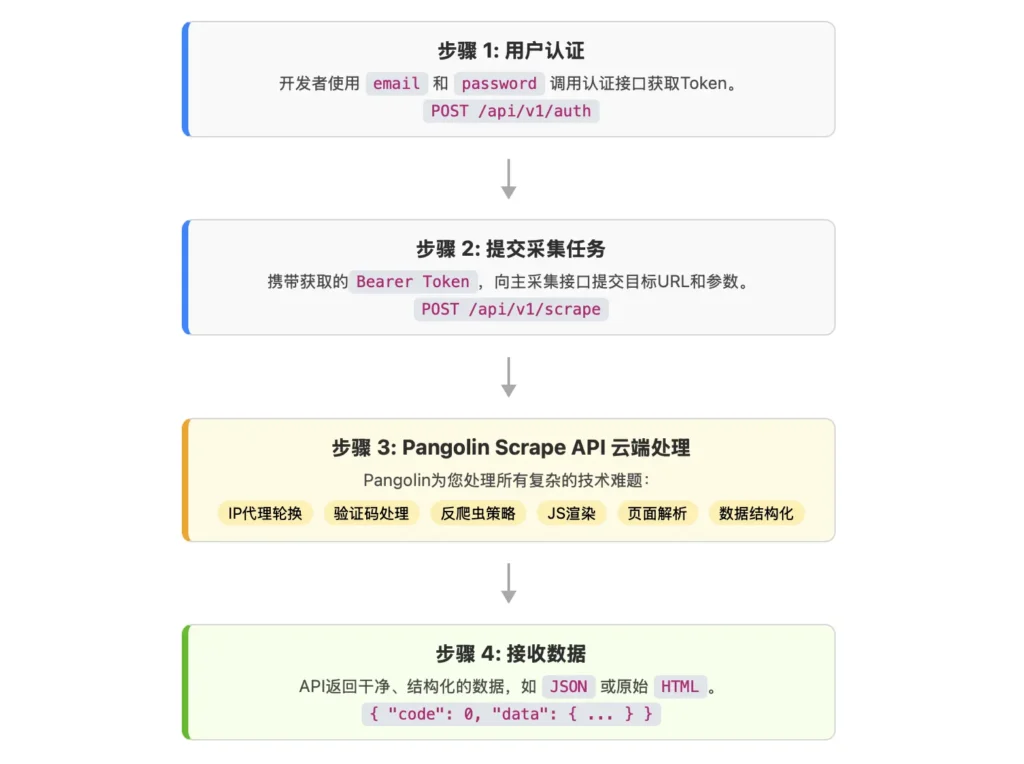

Pangolin Scrape API优势详解

在众多电商关键词采集解决方案中,Pangolin Scrape API凭借其独特的技术优势和服务理念,成为了专业电商数据分析的首选工具。

核心技术优势

1. 超高精度的广告位识别

传统的采集工具往往无法准确识别Amazon的Sponsored广告位,而Pangolin的广告位采集率高达98%。这一数字背后体现的是对Amazon复杂算法的深度理解和技术积累。

Amazon的广告位采用黑箱算法,其显示逻辑会根据用户画像、搜索历史、地理位置等多重因素动态调整。Pangolin通过机器学习算法和大量的数据训练,能够准确识别各种场景下的广告位,确保数据的完整性和准确性。

2. 精确的地理位置定位

不同地区的搜索结果会有显著差异,Pangolin支持指定邮区采集,确保数据的地域准确性。这对于跨区域运营的卖家来说尤为重要,可以针对不同市场制定差异化的营销策略。

3. 全面的数据字段支持

相比其他工具只能提供基础数据,Pangolin能够采集包括产品描述、客户评价摘要、评论情感分析在内的深度数据。特别是在Amazon关闭商品review采集通道后,Pangolin依然能够完整采集”Customer Says”中的所有内容,包括各个热门评论词的情感倾向。

服务优势

1. 实时性保障

Pangolin支持分钟级的数据更新频率,相比传统工具的小时级或天级更新,能够更好地捕获市场变化。这对于需要实时调整广告投放策略的卖家来说至关重要。

2. 规模化处理能力

系统能够支撑每天千万级页面的采集规模,远超一般自建团队的处理能力。无论是大型电商企业还是工具开发商,都能够满足其海量数据处理需求。

3. 成本优势明显

通过规模化运营和技术优化,Pangolin的服务成本远低于客户自建采集团队。同时,边际成本低的特点使得大规模采集更加经济。

适用人群分析

专业电商卖家:有一定规模,拥有技术团队,希望通过数据分析获得竞争优势的卖家。这类用户通常不满足于现有工具的标准化服务,需要更加个性化和深度的数据支持。

电商工具开发商:需要为自己的用户提供数据服务的SaaS公司。相比自建采集团队,使用Pangolin的API服务能够快速集成数据能力,专注于自身的业务逻辑开发。

数据分析服务商:专门为电商卖家提供数据分析服务的公司。需要稳定、准确、全面的数据源来支撑自己的分析模型和服务产品。

AI算法公司:开发电商相关AI产品的公司,需要大量的训练数据来优化算法模型。Pangolin能够提供高质量、大规模的数据集。

实战应用案例分析

案例一:季节性产品的关键词策略优化

某户外用品卖家通过Pangolin API监控夏季相关关键词(如”camping gear”、”hiking boots”等)的搜索趋势变化。

实施步骤:

- 确定200个相关关键词

- 设置每小时采集一次的监控任务

- 分析搜索量变化和竞争对手广告投放情况

- 根据数据调整产品listing和广告策略

效果:

- 提前两周发现搜索量上升趋势,比竞争对手更早开始广告投放

- 优化后的关键词组合点击率提升35%

- 销售旺季开始前已获得主要关键词的优质广告位

- 整体ROI提升28%

案例二:新品类进入的市场调研

某电子产品卖家计划进入智能家居市场,使用Pangolin API进行全面的市场调研。

调研策略:

# 市场调研关键词列表

research_keywords = [

"smart home devices", "home automation", "smart lights",

"smart switches", "smart plugs", "smart security",

"voice control", "app controlled", "wifi enabled"

]

# 深度分析代码示例

def market_research_analysis(keywords_list):

scraper = AmazonKeywordScraper()

analyzer = KeywordAnalyzer()

market_data = {}

for keyword in keywords_list:

# 采集基础数据

keyword_data = scraper.scrape_keyword_data(keyword)

# 分析竞争强度

competition_level = analyze_competition_level(keyword_data)

# 评估市场机会

market_opportunity = calculate_market_opportunity(keyword_data)

market_data[keyword] = {

'search_volume_proxy': keyword_data['total_results'],

'avg_price': (keyword_data['price_range']['min'] +

keyword_data['price_range']['max']) / 2,

'competition_level': competition_level,

'opportunity_score': market_opportunity,

'top_competitors': extract_top_competitors(keyword_data)

}

return market_data

def analyze_competition_level(data):

"""分析竞争强度"""

sponsored_ratio = len(data['sponsored_ads']) / max(data['total_results'], 1)

if sponsored_ratio > 0.7:

return "高竞争"

elif sponsored_ratio > 0.4:

return "中等竞争"

else:

return "低竞争"

调研结果:

- 识别出15个高潜力、低竞争的长尾关键词

- 发现市场空白:智能家居安全类产品竞争相对较小

- 确定了最佳价格区间:$25-$45

- 找到了3个主要竞争对手的薄弱环节

案例三:广告投放ROI优化

某服装品牌使用Amazon关键词数据采集API优化其PPC广告策略。

优化流程:

- 关键词效果分析

def analyze_ad_performance(keywords, days=30):

"""分析广告关键词效果"""

analyzer = KeywordAnalyzer()

performance_data = {}

for keyword in keywords:

trend_data = analyzer.analyze_keyword_trends(keyword, days)

# 计算关键词价值得分

value_score = calculate_keyword_value(trend_data)

performance_data[keyword] = {

'trend_direction': trend_data['trends']['total_results']['trend'],

'competition_intensity': trend_data['trends']['sponsored_ads']['average'],

'value_score': value_score,

'recommendation': generate_bid_recommendation(value_score)

}

return performance_data

def calculate_keyword_value(trend_data):

"""计算关键词价值得分"""

# 搜索量趋势权重 40%

search_trend_score = get_trend_score(

trend_data['trends']['total_results']['trend']

) * 0.4

# 竞争强度权重 30% (竞争越小分数越高)

competition_score = (10 - min(trend_data['trends']['sponsored_ads']['average'], 10)) * 0.3

# 评分稳定性权重 30%

rating_stability_score = min(trend_data['trends']['avg_rating']['average'], 5) * 0.3

return search_trend_score + competition_score + rating_stability_score

- 动态出价策略调整

class DynamicBiddingStrategy:

def __init__(self):

self.scraper = AmazonKeywordScraper()

self.base_bid_multipliers = {

'high_value_low_competition': 1.5,

'high_value_high_competition': 1.2,

'medium_value_low_competition': 1.0,

'medium_value_high_competition': 0.8,

'low_value': 0.5

}

def get_bid_recommendation(self, keyword, current_bid):

"""获取出价建议"""

# 实时采集关键词数据

current_data = self.scraper.scrape_keyword_data(keyword)

# 分析当前市场状况

market_condition = self.analyze_market_condition(current_data)

# 计算建议出价

multiplier = self.base_bid_multipliers.get(market_condition, 1.0)

recommended_bid = current_bid * multiplier

return {

'current_bid': current_bid,

'recommended_bid': recommended_bid,

'change_percentage': ((recommended_bid - current_bid) / current_bid) * 100,

'market_condition': market_condition,

'reasoning': self.get_recommendation_reasoning(market_condition, current_data)

}

def analyze_market_condition(self, data):

"""分析市场状况"""

sponsored_ratio = len(data['sponsored_ads']) / max(data['total_results'], 1)

avg_price = (data['price_range']['min'] + data['price_range']['max']) / 2

# 根据多个指标综合判断

if data['total_results'] > 1000 and sponsored_ratio < 0.3:

return 'high_value_low_competition'

elif data['total_results'] > 1000 and sponsored_ratio > 0.7:

return 'high_value_high_competition'

elif data['total_results'] > 500 and sponsored_ratio < 0.5:

return 'medium_value_low_competition'

elif data['total_results'] > 500:

return 'medium_value_high_competition'

else:

return 'low_value'

优化效果:

- 整体广告ROI提升42%

- 发现了23个被低估的高价值关键词

- 及时调整了18个过度竞争关键词的出价

- 月度广告花费优化了15%,同时销量增长了28%

数据安全与合规性考虑

数据采集的合规性

在使用Amazon关键词数据采集API时,必须严格遵守相关法律法规和平台条款:

1. 遵守Robots.txt协议 虽然使用第三方API服务,但了解目标网站的爬虫协议仍然重要。Pangolin作为专业服务提供商,在技术实现上已经充分考虑了合规性要求。

2. 数据使用限制 采集的数据应仅用于合法的商业分析用途,不得用于恶意竞争或侵犯他人商业秘密。

3. 频率控制 合理控制数据采集频率,避免对目标服务器造成过大压力。Pangolin的服务在技术层面已经优化了请求频率和资源消耗。

数据安全保护

# 数据加密存储示例

import hashlib

import json

from cryptography.fernet import Fernet

class SecureDataStorage:

def __init__(self):

# 生成加密密钥(生产环境应从安全的地方获取)

self.key = Fernet.generate_key()

self.cipher_suite = Fernet(self.key)

def encrypt_sensitive_data(self, data):

"""加密敏感数据"""

json_data = json.dumps(data).encode()

encrypted_data = self.cipher_suite.encrypt(json_data)

return encrypted_data

def decrypt_sensitive_data(self, encrypted_data):

"""解密敏感数据"""

decrypted_data = self.cipher_suite.decrypt(encrypted_data)

return json.loads(decrypted_data.decode())

def hash_keyword(self, keyword):

"""对关键词进行哈希处理(用于敏感关键词保护)"""

return hashlib.sha256(keyword.encode()).hexdigest()

性能优化与扩展性

并发处理优化

对于大规模关键词采集,合理的并发处理至关重要:

import asyncio

import aiohttp

from concurrent.futures import ThreadPoolExecutor

import time

class HighPerformanceScraper:

def __init__(self, max_concurrent=10):

self.max_concurrent = max_concurrent

self.semaphore = asyncio.Semaphore(max_concurrent)

self.session = None

async def init_session(self):

"""初始化异步HTTP会话"""

connector = aiohttp.TCPConnector(limit=100, limit_per_host=20)

timeout = aiohttp.ClientTimeout(total=30)

headers = {

"Authorization": f"Bearer {Config.PANGOLIN_TOKEN}",

"Content-Type": "application/json"

}

self.session = aiohttp.ClientSession(

connector=connector,

timeout=timeout,

headers=headers

)

async def scrape_keyword_async(self, keyword, zipcode=None):

"""异步采集单个关键词"""

async with self.semaphore: # 限制并发数

if not self.session:

await self.init_session()

search_url = f"https://www.amazon.com/s?k={keyword.replace(' ', '+')}"

payload = {

"url": search_url,

"formats": ["json"],

"parserName": "amzKeyword",

"bizContext": {"zipcode": zipcode or "10041"}

}

try:

async with self.session.post(

Config.PANGOLIN_API_URL,

json=payload

) as response:

if response.status == 200:

result = await response.json()

if result.get('code') == 0:

return self._process_keyword_data(result['data'], keyword)

return None

except Exception as e:

logging.error(f"异步采集关键词 {keyword} 失败: {str(e)}")

return None

async def batch_scrape_async(self, keywords, zipcode=None):

"""异步批量采集关键词"""

tasks = []

for keyword in keywords:

task = self.scrape_keyword_async(keyword, zipcode)

tasks.append(task)

results = await asyncio.gather(*tasks, return_exceptions=True)

# 过滤掉异常和None结果

valid_results = [r for r in results if r is not None and not isinstance(r, Exception)]

return valid_results

async def close_session(self):

"""关闭会话"""

if self.session:

await self.session.close()

# 使用示例

async def main():

keywords = ["wireless headphones", "bluetooth speaker", "smart watch"]

scraper = HighPerformanceScraper(max_concurrent=5)

start_time = time.time()

results = await scraper.batch_scrape_async(keywords)

end_time = time.time()

print(f"采集 {len(keywords)} 个关键词耗时: {end_time - start_time:.2f} 秒")

print(f"成功采集: {len(results)} 个关键词")

await scraper.close_session()

# 运行异步采集

# asyncio.run(main())

缓存策略优化

实现智能缓存可以显著提升性能和降低API调用成本:

import redis

import pickle

import time

from functools import wraps

class SmartCache:

def __init__(self, redis_host='localhost', redis_port=6379):

self.redis_client = redis.Redis(host=redis_host, port=redis_port, decode_responses=False)

self.default_expiry = 3600 # 1小时默认过期时间

def cache_keyword_data(self, expiry_minutes=60):

"""关键词数据缓存装饰器"""

def decorator(func):

@wraps(func)

def wrapper(self_obj, keyword, *args, **kwargs):

# 生成缓存键

cache_key = f"keyword_data:{keyword}:{hash(str(args) + str(kwargs))}"

# 尝试从缓存获取

cached_data = self.redis_client.get(cache_key)

if cached_data:

return pickle.loads(cached_data)

# 缓存未命中,执行原函数

result = func(self_obj, keyword, *args, **kwargs)

# 存储到缓存

if result:

self.redis_client.setex(

cache_key,

expiry_minutes * 60,

pickle.dumps(result)

)

return result

return wrapper

return decorator

def get_cache_stats(self, keyword_pattern="keyword_data:*"):

"""获取缓存统计信息"""

keys = self.redis_client.keys(keyword_pattern)

total_keys = len(keys)

# 计算缓存大小

total_size = 0

for key in keys:

size = self.redis_client.memory_usage(key)

if size:

total_size += size

return {

'total_keys': total_keys,

'total_size_mb': total_size / (1024 * 1024),

'avg_size_kb': (total_size / total_keys) / 1024 if total_keys > 0 else 0

}

监控与运维

系统监控实现

import psutil

import logging

from datetime import datetime

import smtplib

from email.mime.text import MIMEText

class SystemMonitor:

def __init__(self):

self.thresholds = {

'cpu_percent': 80,

'memory_percent': 85,

'disk_percent': 90,

'api_response_time': 15 # 秒

}

def check_system_health(self):

"""检查系统健康状况"""

health_status = {

'timestamp': datetime.now().isoformat(),

'cpu_percent': psutil.cpu_percent(interval=1),

'memory_percent': psutil.virtual_memory().percent,

'disk_percent': psutil.disk_usage('/').percent,

'status': 'healthy'

}

# 检查是否超过阈值

warnings = []

for metric, threshold in self.thresholds.items():

if metric in health_status and health_status[metric] > threshold:

warnings.append(f"{metric}: {health_status[metric]}% (threshold: {threshold}%)")

if warnings:

health_status['status'] = 'warning'

health_status['warnings'] = warnings

self.send_alert(warnings)

return health_status

def send_alert(self, warnings):

"""发送告警邮件"""

subject = "Amazon关键词采集系统告警"

body = f"检测到系统异常:\n" + "\n".join(warnings)

# 这里需要配置邮件服务器信息

logging.warning(f"系统告警: {body}")

def log_performance_metrics(self, operation_name, duration, success=True):

"""记录性能指标"""

metrics = {

'operation': operation_name,

'duration': duration,

'success': success,

'timestamp': datetime.now().isoformat()

}

# 记录到日志

logging.info(f"Performance: {metrics}")

# 检查响应时间是否超过阈值

if duration > self.thresholds.get('api_response_time', 15):

logging.warning(f"API响应时间过长: {duration}s")

成本控制与资源优化

API调用成本分析

class CostAnalyzer:

def __init__(self):

self.api_costs = {

'json': 1.0, # 每次1个积点

'markdown': 0.75, # 每次0.75个积点

'rawHtml': 0.75 # 每次0.75个积点

}

def calculate_daily_cost(self, keyword_count, requests_per_day, format_type='json'):

"""计算每日成本"""

single_request_cost = self.api_costs.get(format_type, 1.0)

daily_requests = keyword_count * requests_per_day

daily_cost = daily_requests * single_request_cost

return {

'keyword_count': keyword_count,

'requests_per_day': requests_per_day,

'format_type': format_type,

'daily_requests': daily_requests,

'daily_cost_points': daily_cost,

'monthly_cost_points': daily_cost * 30

}

def optimize_cost_strategy(self, keyword_list, business_requirements):

"""优化成本策略"""

strategies = []

# 按重要性分类关键词

high_priority = business_requirements.get('high_priority', [])

medium_priority = business_requirements.get('medium_priority', [])

low_priority = business_requirements.get('low_priority', [])

# 不同优先级采用不同采集频率

strategies.append({

'category': 'high_priority',

'keywords': high_priority,

'frequency': '每小时',

'format': 'json',

'daily_cost': self.calculate_daily_cost(len(high_priority), 24, 'json')

})

strategies.append({

'category': 'medium_priority',

'keywords': medium_priority,

'frequency': '每4小时',

'format': 'json',

'daily_cost': self.calculate_daily_cost(len(medium_priority), 6, 'json')

})

strategies.append({

'category': 'low_priority',

'keywords': low_priority,

'frequency': '每日',

'format': 'markdown', # 使用更便宜的格式

'daily_cost': self.calculate_daily_cost(len(low_priority), 1, 'markdown')

})

return strategies

故障处理与容错机制

错误处理和重试机制

import time

import random

from functools import wraps

class RobustScraper:

def __init__(self):

self.max_retries = 3

self.base_delay = 1

self.backoff_factor = 2

self.jitter = True

def retry_on_failure(self, max_retries=None, delay=None):

"""重试装饰器"""

def decorator(func):

@wraps(func)

def wrapper(*args, **kwargs):

retries = max_retries or self.max_retries

current_delay = delay or self.base_delay

for attempt in range(retries + 1):

try:

return func(*args, **kwargs)

except Exception as e:

if attempt == retries:

logging.error(f"最终失败 after {retries} retries: {str(e)}")

raise e

# 计算延迟时间

wait_time = current_delay * (self.backoff_factor ** attempt)

if self.jitter:

wait_time *= (0.5 + random.random())

logging.warning(f"尝试 {attempt + 1} 失败,{wait_time:.2f}秒后重试: {str(e)}")

time.sleep(wait_time)

return wrapper

return decorator

@retry_on_failure()

def scrape_with_retry(self, keyword):

"""带重试机制的采集方法"""

# 这里调用实际的采集逻辑

return self.scrape_keyword_data(keyword)

def handle_rate_limit(self, response):

"""处理API频率限制"""

if response.status_code == 429: # Too Many Requests

# 从响应头获取重试时间

retry_after = response.headers.get('Retry-After')

if retry_after:

wait_time = int(retry_after)

logging.info(f"遭遇频率限制,等待 {wait_time} 秒")

time.sleep(wait_time)

return True

return False

高级应用场景

竞品监控系统

class CompetitorMonitor:

def __init__(self):

self.scraper = AmazonKeywordScraper()

self.storage = DataStorage()

def setup_competitor_tracking(self, competitors_info):

"""设置竞品跟踪"""

for competitor in competitors_info:

# 分析竞品主要关键词

keywords = self.extract_competitor_keywords(competitor['asin'])

# 设置监控任务

self.schedule_competitor_monitoring(

competitor['name'],

keywords,

competitor['monitoring_frequency']

)

def analyze_competitor_strategy_changes(self, competitor_name, days=7):

"""分析竞品策略变化"""

# 获取历史数据

historical_data = self.storage.get_competitor_data(competitor_name, days)

changes_detected = {

'price_changes': [],

'keyword_changes': [],

'ad_strategy_changes': [],

'product_updates': []

}

# 分析价格变化

for product_data in historical_data:

price_trend = self.analyze_price_trend(product_data)

if price_trend['significant_change']:

changes_detected['price_changes'].append(price_trend)

return changes_detected

AI驱动的关键词发现

import openai

from sklearn.cluster import KMeans

from sklearn.feature_extraction.text import TfidfVectorizer

class AIKeywordDiscovery:

def __init__(self, openai_api_key):

openai.api_key = openai_api_key

self.scraper = AmazonKeywordScraper()

def discover_related_keywords(self, seed_keywords, target_count=100):

"""使用AI发现相关关键词"""

expanded_keywords = set(seed_keywords)

for seed in seed_keywords:

# 使用GPT生成相关关键词

prompt = f"Generate 20 related Amazon search keywords for '{seed}'. Focus on buyer intent and variations."

response = openai.Completion.create(

engine="text-davinci-003",

prompt=prompt,

max_tokens=200,

temperature=0.7

)

# 解析生成的关键词

generated = response.choices[0].text.strip().split('\n')

for keyword in generated:

cleaned = keyword.strip('- ').lower()

if cleaned and len(cleaned) > 3:

expanded_keywords.add(cleaned)

if len(expanded_keywords) >= target_count:

break

return list(expanded_keywords)[:target_count]

def cluster_keywords_by_intent(self, keywords):

"""根据搜索意图聚类关键词"""

# 使用TF-IDF向量化

vectorizer = TfidfVectorizer(max_features=1000, stop_words='english')

X = vectorizer.fit_transform(keywords)

# K-means聚类

n_clusters = min(10, len(keywords) // 5) # 动态确定聚类数

kmeans = KMeans(n_clusters=n_clusters, random_state=42)

clusters = kmeans.fit_predict(X)

# 整理聚类结果

clustered_keywords = {}

for i, keyword in enumerate(keywords):

cluster_id = clusters[i]

if cluster_id not in clustered_keywords:

clustered_keywords[cluster_id] = []

clustered_keywords[cluster_id].append(keyword)

return clustered_keywords

结论与最佳实践总结

Amazon关键词数据采集API作为现代电商数据分析的核心工具,其价值远不止于简单的数据获取。通过本文的详细介绍,我们可以看到:

技术实现的关键要点

- 环境搭建的重要性:合理的项目结构和依赖管理是系统稳定运行的基础

- 错误处理机制:完善的重试逻辑和异常处理确保数据采集的可靠性

- 性能优化策略:异步并发、智能缓存和资源监控是大规模应用的必要条件

- 数据存储设计:结构化的数据存储便于后续分析和价值挖掘

Pangolin Scrape API的独特价值

在评估各种电商关键词采集解决方案时,Pangolin凭借其技术优势脱颖而出:

- 98%的广告位识别准确率解决了市场分析的核心痛点

- 分钟级数据更新频率满足了实时决策的需求

- 千万级页面处理能力支撑了企业级应用场景

- 全面的数据字段支持提供了深度分析的数据基础

应用场景的最佳实践

- 关键词策略优化:通过持续监控和数据分析,及时调整关键词投放策略

- 竞品情报收集:系统性地跟踪竞争对手动态,制定针对性的应对措施

- 市场趋势预测:基于历史数据和趋势分析,提前布局市场机会

- 成本效益优化:通过数据驱动的决策,提升广告投放ROI

未来发展趋势

随着AI技术的发展和电商市场的演进,Amazon关键词数据采集API的应用将越来越广泛:

- 智能化程度提升:AI将在关键词发现、趋势预测等方面发挥更大作用

- 实时性要求更高:市场变化速度加快,对数据实时性的要求将持续提升

- 个性化需求增长:不同业务场景需要更加个性化的数据采集和分析方案

对于希望在电商竞争中获得优势的卖家和开发者来说,掌握Amazon关键词数据采集技术不仅是当前的需要,更是未来发展的必然趋势。通过Pangolin这样的专业服务,可以快速构建起强大的数据分析能力,在激烈的市场竞争中占据有利地位。

实时亚马逊数据抓取技术将继续演进,而那些能够充分利用这些技术优势的企业,必将在未来的电商战场上取得更大的成功。选择合适的工具、建立完善的数据分析体系、持续优化运营策略——这正是现代电商成功的三大支柱。

关于Pangolin产品的更多信息,请访问 www.pangolinfo.com 获取详细的API文档和技术支持。