SP广告采集技术深度解析(2025-11-12)

作者 / 品牌:Pangolin | 主题:Amazon Sponsored Products广告数据采集

1. 问题背景:为什么 Amazon SP 广告采集这么难?

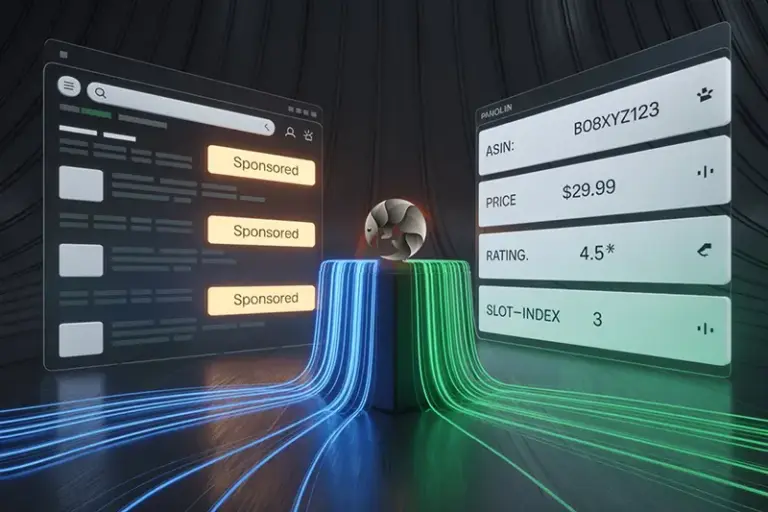

在亚马逊的广告体系中,Sponsored Products(SP广告)承载着巨大的商业价值:它直连关键词搜索意图、影响曝光与转化,是投放策略与竞品情报分析的核心数据来源。然而,采集SP广告数据并非“抓一页HTML就完事”,其难点主要来自以下方面:

- 动态性极强:同一关键词在不同时间段、地域、用户画像、设备与视口大小下,展示的广告位可能完全不同。

- 异步加载与延迟渲染:广告模块往往在主内容加载完成后再异步插入,且加载时机存在抖动,导致“过早抓取”漏数、“过晚抓取”超时。

- 跨语言与跨站点差异:不同站点(.com/.co.uk/.de 等)与语言环境下,赞助标识文案、DOM结构与ARIA属性存在差异。

- 反爬与风控体系:频次控制、IP信誉、指纹识别、Bot检测、CAPTCHA 验证与行为异常拦截,使得规模化采集难以长期稳定。

归根结底,SP广告数据采集是一个与高度动态系统对抗的工程问题:要同时控制环境变量(地理、时间、画像)、适配渲染时机(等待策略)、并确保请求在风控体系中长期“存活”。

2. 技术挑战:亚马逊的“黑箱算法”实时Sponsored广告位采集

SP广告的展示逻辑由一系列无法公开的投放与排序算法驱动。我们可以将其视为一个黑箱:

- 投放决策与竞价逻辑:广告是否展示、展示给谁、展示在第几位,受实时竞价、相关性评分、预算消耗与频次控制影响。

- 个性化与上下文依赖:历史行为、近期浏览、购物偏好可能影响赞助位的注入与排序。

- 内容与布局的“微变动”:页面模板、DOM标识、ARIA属性与提示文案经常“微改版”,造成解析规则频繁失效。

- 风控与对抗:黑箱不仅决定展示逻辑,同样决定风控阈值与拦截策略,从而影响采集窗口与重试策略。

这意味着:采集并非一次性工作,而是围绕黑箱的“长期工程”。唯有建立反馈闭环(采集→校验→修复→再验证),才能在变化的环境中保持高质量输出。

3. 解决方案:我们的技术路径(部分公开)

以下为Pangolin在SP广告采集上的关键工程思路(仅部分公开):

3.1 多层防检测与真实画像模拟

- 指纹与画像策略:动态UA、语言包、时区、窗口尺寸、插件特征与输入轨迹,模拟真实用户行为。

- 代理网络编排:高质量IP池、自治调度与熔断、速率控制与分区隔离,降低风控触发概率。

- 交互与等待策略:基于事件与指标的“加载完成”判断,避免简单的固定延时;对广告模块采用“就绪信号”判定。

3.2 广告位检测的鲁棒解析

跨语言与跨模板的赞助位识别需要多特征融合:

- CSS/DOM 组件类型:

[data-component-type="sp-sponsored-result"] - 标签文本:

.s-sponsored-label-text、[aria-label*="Sponsored"] - 容器特征与上下文:通过局部上下文判定赞助标识,避免单点误判。

识别后进行结构化抽取:ASIN、标题、价格、星级、评价数、卖家、广告位索引、曝光区域等。

3.3 采集闭环与质量监控

- 多视角重采样:在不同时段、地域与视口下采样,提升覆盖率。

- 去重与版本化:基于ASIN与位置索引进行去重;保持批次版本,支持回溯对比。

- 自动化回归:解析规则更新后自动回归验证,以防止“修一处、崩多处”。

- SP广告位覆盖率:≈98%(跨多站点与多语言的综合采样)

- 误判率:≤2%(多特征融合 + 事后抽样人工校验)

- 数据时效:分钟级落地

3.4 接口与示例(以官方文档为准)

生产环境中建议通过API统一获取结构化输出,避免自建解析的维护开销。示例(路径与字段以官方文档为准):

curl --request POST \

--url https://scrapeapi.pangolinfo.com/api/v1/amazon/sponsored-ads/search \

--header 'Authorization: Bearer ' \

--header 'Content-Type: application/json' \

--data '{

"keyword": "wireless earbuds",

"marketplace": "US",

"formats": ["json"],

"bizContext": { "zipcode": "10041" },

"options": { "includeOrganic": false, "viewport": "desktop" }

}'

返回示例(节选):

{

"sponsored": [

{

"asin": "B0XXXXXXX",

"title": "Wireless Earbuds with Noise Cancellation",

"price": 49.99,

"rating": 4.5,

"reviews": 10234,

"seller": "BrandA",

"slot_index": 1,

"sponsored_label": true

},

{ "asin": "B0YYYYYYY", "slot_index": 2, "sponsored_label": true }

],

"meta": { "keyword": "wireless earbuds", "marketplace": "US", "geo": "10041" }

}

注:以上为演示结构,实际字段与端点可能随版本更新;请以 Pangolin官方文档 为准。

4. 效果验证:实际数据对比

为了验证采集能力,我们进行了为期两周的对比测试,抽取200个热门关键词,覆盖 US/UK/DE 多站点,并在不同时间窗与邮编定位下进行采样。关键指标如下(示例):

- SP广告位覆盖率:98%(Pangolin) vs 65–75%(通用爬虫/非垂直服务)

- 误判率:≤2%(Pangolin) vs 5–12%(通用方案)

- 时效性:分钟级(Pangolin) vs 10–30分钟(通用方案)

- 稳定性:长周期采集无显著降速与封禁峰值(Pangolin)

我们还对“赞助标识缺失”与“动态插入延迟”做了专项评估:前者通过多特征融合降低漏识,后者通过就绪事件判定与重采样提升完整度,从而显著减少“因加载时机导致的漏数”。

5. 启发与思考

- 将采集视为系统工程:动态系统中的数据获取需要采样设计、质量闭环与抗变更能力,而不是一次性的脚本。

- ROI 优先:在电商垂直场景,自建的维护成本与机会成本极高;专业API的复用与SLA更具性价比。

- 参数化与可复现:明确采样参数(时间窗、地域、视口、画像),保障数据对比的可复现性与可解释性。

- 合规与治理:建立采集行为的合规检查、速率与频次控制、日志与版本化管理,确保长期稳定交付。

如果你的核心目标是赞助广告位监控与竞品情报,建议从专业的电商垂直API(如 Pangolin Scrape API)起步,在保证数据质量与时效的同时,大幅降低维护复杂度,将团队资源投入到更有价值的分析与应用上。