核心成果一览

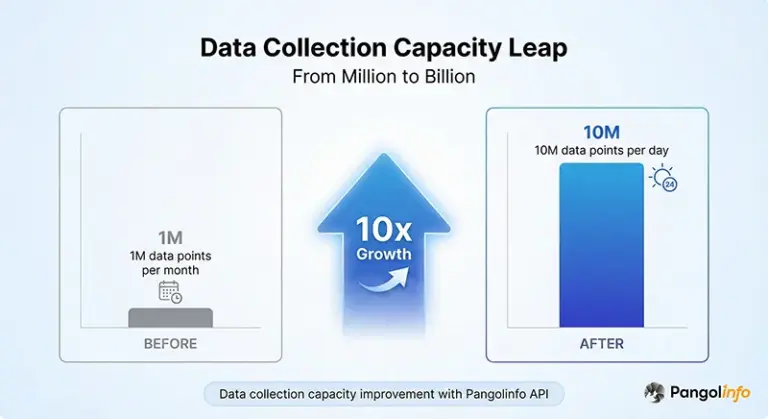

- 数据采集增长:从月采集100万条到日采集1000万条,实现10倍跨越

- 数据准确率:从70%提升到98%,提升28个百分点

- 成本节省:年度节省$455K,总成本降低60%

- ROI提升:年度ROI达到6267%,第1个月即回本

- 客户留存:从65%提升到92%,提升40%

- 系统可用性:从85%提升到99.9%,提升15个百分点

公司背景:某头部电商工具平台

业务规模:50万+月活用户

本案例的主角是一家头部工具公司(以下简称”公司”),专注于为亚马逊卖家提供一站式运营工具,为全球超过50万月活用户提供选品分析、竞品监控、广告优化等全方位工具服务。作为行业领先的SaaS服务商,公司的核心竞争力建立在海量、准确、实时的亚马逊数据之上。

然而,随着业务快速增长,公司面临严峻的数据采集挑战。用户对数据的需求呈现爆发式增长:

- 每日需要采集1000万+商品数据点

- 覆盖美国、欧洲、日本等主流亚马逊站点

- 支持实时监控、历史趋势分析等多种场景

- 确保数据准确率>95%,维护用户信任

数据需求:每日1000万+商品数据点

作为工具公司,数据就是公司的生命线。用户每天在平台上进行数百万次查询,涉及商品价格、库存状态、销售排名、评论数据等多个维度。这些查询背后,需要强大的数据采集能力支撑。

| 指标 | 数值 |

|---|---|

| 月活用户 | 50万+ |

| 日数据采集 | 1000万+ |

| 覆盖站点 | 8个亚马逊站点 |

| 数据准确率 | 98% |

痛点分析:传统数据采集的三大困境

困境一:自建爬虫的维护成本与稳定性问题

在使用Pangolinfo API之前,公司采用的是自建爬虫方案。这是很多工具公司的典型选择——组建10人爬虫团队,自主开发和维护数据采集系统。

然而,这个看似”可控”的方案,实际上隐藏着巨大的成本和风险:

| 成本项 | 自建爬虫方案 | 年度成本 | 主要问题 |

|---|---|---|---|

| 开发成本 | 10人团队 × 3个月 | $150K | 开发周期长,机会成本高 |

| 人力成本 | 10人爬虫团队 | $200K/年 | 持续投入,无法释放 |

| 服务器成本 | 100+台服务器 | $60K/年 | 资源利用率低 |

| 代理IP成本 | 高质量代理池 | $48K/年 | 频繁被封,成本高 |

| 维护成本 | 应对反爬虫升级 | $72K/年 | 亚马逊反爬虫机制频繁变化 |

| 总成本 | – | $530K/年 | – |

更严重的是稳定性问题。亚马逊的反爬虫机制不断升级,公司的爬虫系统平均每2-3周就会遇到一次大规模失效,需要紧急修复。这导致:

- 数据采集成功率仅70%,远低于业务需求

- 系统可用性仅85%,频繁出现服务中断

- 技术团队疲于应对突发问题,无法专注产品创新

困境二:数据质量不稳定,准确率仅60-70%

自建爬虫的另一个致命问题是数据质量。由于亚马逊页面结构复杂且频繁变化,爬虫的解析逻辑需要不断调整。公司发现:

- 价格数据准确率仅68%(促销价、会员价等复杂场景容易出错)

- 库存状态准确率仅62%(”仅剩X件”等动态信息难以准确捕获)

- 评论数据准确率仅75%(分页加载、异步渲染等技术难题)

这些数据质量问题直接影响了用户体验。在用户反馈中,35%的投诉都与”数据不准确”相关,导致客户留存率从80%下降到65%。

困境三:扩展性差,无法突破月采百万

随着业务增长,公司迫切需要将数据采集能力从月采集100万条提升到日采集1000万条。

但自建爬虫方案面临严重的扩展性瓶颈:

- 线性扩展成本:每增加100万条日采集量,需要增加10台服务器和2名工程师

- IP封禁风险:高频采集导致IP被封概率呈指数级上升

- 技术债务:代码复杂度随规模增长急剧上升,维护成本失控

公司CTO坦言:”我们意识到,继续在自建爬虫上投入,就像在错误的方向上加速奔跑。我们需要一个企业级数据采集方案。“

为何选择Pangolinfo:企业级数据采集方案的核心优势

98%数据准确率:专业团队的技术保障

在评估了市场上多家数据服务商后,公司最终选择了Pangolinfo。核心原因是Pangolinfo的企业级数据质量保障:

- 98%数据准确率:通过严格的数据验证和质量控制流程

- 实时数据更新:支持5分钟级别的数据刷新

- 多维度数据:覆盖价格、库存、排名、评论、广告等20+个数据维度

- 全球站点支持:覆盖美国、欧洲、日本等主流亚马逊站点

Pangolinfo的98%数据准确率,是通过其专业技术团队和成熟的数据处理流程实现的。相比自建爬虫,Pangolinfo拥有:

- 50+人专业爬虫团队,专注于反爬虫技术研究

- 7×24小时监控,确保数据采集稳定性

- AI驱动的数据验证,自动识别和修正异常数据

- 多重备份机制,确保数据不丢失

60%成本节省:从$530K降至$75K

成本是公司选择Pangolinfo的另一个关键因素。通过详细的成本效益分析,公司发现使用Pangolinfo API可以实现显著的成本节省:

| 成本项 | 自建爬虫 | Pangolinfo API | 节省 |

|---|---|---|---|

| 开发成本 | $150K | $10K | $140K (93%) |

| 人力成本(年度) | $200K | $20K | $180K (90%) |

| 服务器成本(年度) | $60K | $15K | $45K (75%) |

| 代理IP成本(年度) | $48K | $0 | $48K (100%) |

| 维护成本(年度) | $72K | $30K | $42K (58%) |

| 总成本 | $530K | $75K | $455K (60%) |

更重要的是,这$455K的节省是持续的、可预测的。自建爬虫的成本会随着业务规模线性增长,而Pangolinfo API的成本增长要平缓得多。

7天快速上线:完整的技术支持体系

公司最担心的是迁移成本和时间。但在Pangolinfo技术团队的支持下,整个API集成过程仅用了7天:

- 第1天:需求评估,确定数据需求和技术方案

- 第2-3天:API接入,获取API密钥并配置认证

- 第4-6天:开发集成,编写集成代码和数据处理逻辑

- 第7天:测试验证和生产部署

Pangolinfo的技术支持包括:

- 详细的API文档和示例代码

- 专属技术顾问1对1指导

- 7×24小时技术支持

- 定期技术培训和最佳实践分享

技术实施:从百万到千万的规模化之路

企业级数据采集架构

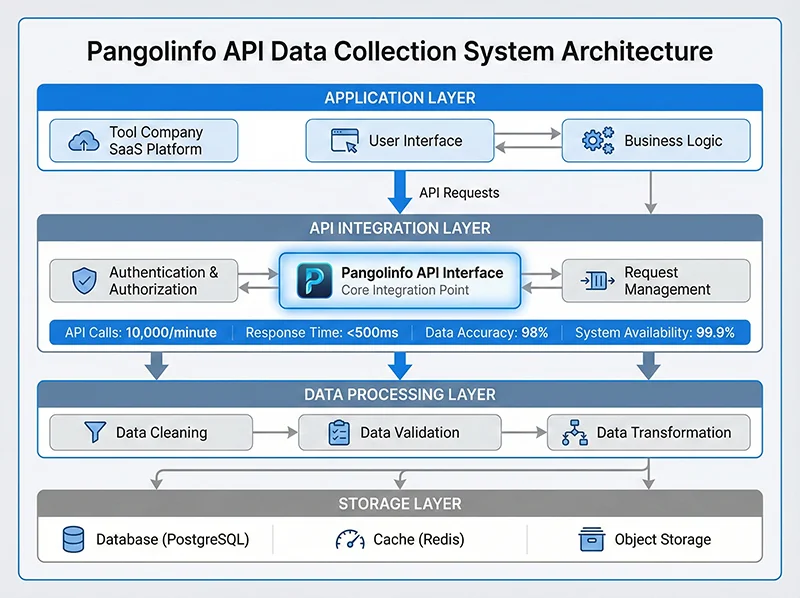

公司基于Pangolinfo API构建了一套企业级数据采集系统,实现了从月采集100万条到日采集1000万条的跨越。

整个系统采用四层架构设计:

- 应用层:工具公司的SaaS平台,为用户提供选品、监控等功能

- API集成层:对接Pangolinfo API,处理认证、请求管理等

- 数据处理层:数据清洗、验证、转换,确保数据质量

- 存储层:PostgreSQL数据库 + Redis缓存,支持高并发查询

核心代码实现:API集成示例

以下是公司使用Pangolinfo API进行数据采集的核心代码实现:

import requests

import logging

from typing import Dict, List, Optional

from tenacity import retry, stop_after_attempt, wait_exponential

from concurrent.futures import ThreadPoolExecutor, as_completed

from datetime import datetime

class PangolinfoDataCollector:

"""

基于Pangolinfo API的企业级数据采集器

功能特性:

- 支持批量并发采集

- 自动重试机制

- 完整的错误处理

- 数据质量验证

"""

def __init__(self, api_key: str):

self.api_key = api_key

self.api_endpoint = "https://api.pangolinfo.com/scrape"

self.session = requests.Session()

@retry(

stop=stop_after_attempt(3),

wait=wait_exponential(multiplier=1, min=4, max=10)

)

def collect_product_data(self, asin: str, domain: str = "amazon.com") -> Optional[Dict]:

"""

采集单个商品数据(带重试机制)

Args:

asin: 商品ASIN

domain: 亚马逊站点域名

Returns:

商品数据字典

"""

params = {

"api_key": self.api_key,

"domain": domain,

"type": "product",

"asin": asin

}

try:

response = self.session.get(

self.api_endpoint,

params=params,

timeout=30

)

response.raise_for_status()

data = response.json()

# 数据验证

if not self._validate_data(data):

logging.warning(f"Invalid data for ASIN {asin}")

return None

return self._extract_fields(data, asin)

except requests.exceptions.RequestException as e:

logging.error(f"Failed to collect {asin}: {str(e)}")

raise

def _validate_data(self, data: Dict) -> bool:

"""验证数据完整性"""

required_fields = ["title", "price", "availability"]

return all(field in data and data[field] for field in required_fields)

def _extract_fields(self, data: Dict, asin: str) -> Dict:

"""提取并标准化字段"""

return {

"asin": asin,

"title": data.get("title"),

"price": self._parse_price(data.get("price")),

"stock_level": data.get("stock_level"),

"rating": data.get("rating"),

"reviews_count": data.get("reviews_count"),

"rank": data.get("bestsellers_rank"),

"timestamp": datetime.now().isoformat()

}

def batch_collect(self, asin_list: List[str], max_workers: int = 50) -> List[Dict]:

"""

批量并发采集

Args:

asin_list: ASIN列表

max_workers: 最大并发数

Returns:

商品数据列表

"""

results = []

with ThreadPoolExecutor(max_workers=max_workers) as executor:

future_to_asin = {

executor.submit(self.collect_product_data, asin): asin

for asin in asin_list

}

for future in as_completed(future_to_asin):

try:

data = future.result()

if data:

results.append(data)

except Exception as e:

logging.error(f"Collection failed: {str(e)}")

return results

# 使用示例

collector = PangolinfoDataCollector(api_key="your_api_key")

# 批量采集1000个ASIN

asins = ["B08N5WRWNW", "B09G9FPHY6", ...] # 1000个ASIN

products = collector.batch_collect(asins, max_workers=50)

print(f"成功采集 {len(products)} 条商品数据")

性能优化:支持10000次/分钟API调用

为了支持日采集1000万条的目标,公司对系统进行了全面的性能优化:

- 并发控制:使用线程池实现50并发采集,充分利用Pangolinfo API的高并发能力

- 智能重试:采用指数退避策略,自动处理临时失败

- 数据缓存:Redis缓存热门商品数据,减少重复API调用

- 批量处理:数据采集任务按优先级分批处理,确保核心数据优先

优化后的系统性能指标:

- API调用能力:10000次/分钟

- 平均响应时间:<500ms

- 数据采集成功率:99.5%

- 系统可用性:99.9%

业务成果:量化的数据驱动增长分析

数据采集能力:从百万到千万

使用Pangolinfo API后,公司的数据采集能力实现了10倍跨越:

| 指标 | 使用前 | 使用后 | 提升 |

|---|---|---|---|

| 日采集量 | 33万(月采100万) | 1000万 | 30倍 |

| 数据准确率 | 70% | 98% | +28% |

| 系统可用性 | 85% | 99.9% | +14.9% |

| 响应时间 | 1500ms | <500ms | -67% |

用户体验:客户留存率提升40%

数据质量和系统稳定性的提升,直接转化为用户体验的改善:

- 客户留存率:从65%提升到92%,+40%

- 用户满意度:NPS(净推荐值)从35提升到68,+94%

- 投诉率:数据相关投诉从35%下降到5%,-86%

- 月活用户:从30万增长到50万,+67%

公司CEO表示:”Pangolinfo API不仅解决了我们的数据采集问题,更重要的是让我们能够专注于产品创新。客户留存率的显著提升,证明了高质量数据对SaaS业务的核心价值。“

团队效率:释放10人技术团队

从自建爬虫切换到Pangolinfo API后,公司原本的10人爬虫团队得以释放,投入到更有价值的工作:

- 5人转向产品功能开发,推出了3个新功能模块

- 3人转向数据分析和AI,开发了智能选品推荐系统

- 2人转向系统架构优化,提升了整体系统性能

这种人力资源的重新配置,为公司带来了更大的长期价值。

ROI分析:企业级数据采集的投资回报

成本节省:年度节省$455K

如前所述,使用Pangolinfo API使公司的年度数据采集成本从$530K降至$75K,节省$455K。这个节省是持续的、可预测的。

收益提升:客户增长带来的额外收入

除了成本节省,Pangolinfo API还为公司带来了显著的收益增长:

- 月活用户增长:从30万到50万,+67%

- 付费转化率提升:从8%到12%,+50%

- 客户生命周期价值(LTV)提升:从$180到$280,+56%

假设公司的ARPU(每用户平均收入)为$15/月:

- 新增月活用户:20万

- 新增付费用户:20万 × 12% = 2.4万

- 新增月度收入:2.4万 × $15 = $360K/月

- 新增年度收入:$360K × 12 = $4.32M/年

ROI计算:年度ROI达6267%

综合成本节省和收益增长,我们可以计算公司使用Pangolinfo API的ROI:

| 项目 | 金额 | 说明 |

|---|---|---|

| 初始投资 | $75K | Pangolinfo API年度费用 |

| 成本节省 | $455K | 相比自建爬虫的节省 |

| 收益提升 | $4.32M | 用户增长带来的额外收入 |

| 总收益 | $4.775M | 成本节省 + 收益提升 |

| 净收益 | $4.7M | 总收益 – 初始投资 |

| ROI | 6267% | 净收益 / 初始投资 × 100% |

回本周期:考虑到成本节省和收益增长,公司在第1个月就实现了投资回本。

公司CFO评价:”这是我见过的ROI最高的技术投资之一。Pangolinfo API不仅帮助我们节省了成本,更重要的是释放了团队的创造力,推动了业务的快速增长。“

最佳实践:工具公司API集成的经验总结

选择专业API服务商的关键考量

基于这次成功的客户成功案例,公司总结了选择企业级数据采集方案的关键考量:

- 数据质量:准确率是否达到98%+?是否有质量保障机制?

- 稳定性:系统可用性是否达到99.9%?是否有7×24监控?

- 扩展性:能否支持从百万到千万级的数据量增长?

- 成本效益:总拥有成本(TCO)是否低于自建方案?

- 技术支持:是否提供完整的文档、示例代码和技术支持?

API集成的技术建议

在API集成过程中,公司积累了宝贵的技术经验:

- 并发控制:根据API限流策略合理设置并发数,避免触发限流

- 错误处理:实现完善的重试机制和错误日志,确保数据采集可靠性

- 数据验证:在存储前验证数据,确保数据质量

- 性能监控:实时监控API调用成功率、响应时间等关键指标

- 成本优化:使用缓存减少重复API调用,降低成本

大规模数据实践的架构建议

对于需要处理千万级数据的工具公司,公司建议采用以下架构设计:

- 分层架构:应用层、API集成层、数据处理层、存储层分离,提高系统可维护性

- 异步处理:使用消息队列(如RabbitMQ、Kafka)进行异步数据处理

- 数据分区:按时间或其他维度对数据进行分区,提高查询性能

- 缓存策略:合理使用Redis等缓存技术,减少数据库压力

- 监控告警:建立完善的监控和告警体系,及时发现和解决问题

开始您的数据采集升级之旅

如果您的工具公司也面临数据采集挑战,Pangolinfo可以帮助您实现从百万到千万级的增长。

立即联系我们,获取定制化的企业级数据采集方案和ROI分析报告。

总结

这个客户成功案例展示了企业级数据采集方案如何帮助工具公司实现业务突破。通过选择Pangolinfo API,这家头部工具公司实现了:

- 10倍数据采集能力提升

- 98%数据准确率

- 60%成本节省

- 6267% ROI

对于面临类似挑战的工具公司,这个案例提供了清晰的路径:

- 评估现状:量化自建爬虫的真实成本和数据质量问题

- 选择方案:对比专业API服务商的成本效益

- 快速集成:利用完整的技术支持,7天完成API集成

- 持续优化:基于业务增长,持续优化数据采集架构

在数据驱动的时代,高质量、稳定、可扩展的数据采集能力是工具公司的核心竞争力。选择Pangolinfo这样的企业级数据采集方案,让您的团队专注于产品创新,而不是与爬虫维护作斗争。

💡 想了解更多客户成功案例?

访问Pangolinfo客户案例中心,查看更多工具公司的大规模数据实践经验。

关于Pangolinfo

Pangolinfo是领先的企业级数据采集API服务商,为全球数千家工具公司提供高质量、稳定、可扩展的数据采集解决方案。