本文关键词:构建Amazon产品监控系统、亚马逊价格监控脚本、Python监控亚马逊竞品、实时商品数据采集方案、亚马逊自动化监控流程

终极指南:如何从零构建Amazon产品监控系统

在亚马逊这个瞬息万变的商业生态中,谁能最快地响应市场变化,谁就能掌握主动权。无论是竞争对手的价格调整、库存清空,还是Buy Box的易主,这些关键信号都可能在几分钟内发生。因此,搭建一个自动化的Amazon产品监控API或系统,实现对关键商品的实时追踪,已成为高阶卖家和数据分析公司的核心竞争力。

本文不是一篇简单的工具推荐,而是一份详尽的技术实现蓝图。我们将从系统架构设计讲起,手把手带您探讨如何利用常见的技术栈(如Python、数据库、任务调度器),从零开始构建一个属于您自己的、功能完备的亚马逊产品监控系统,并分析在最关键的“数据采集”环节,为何使用专业的API会是更明智的选择。

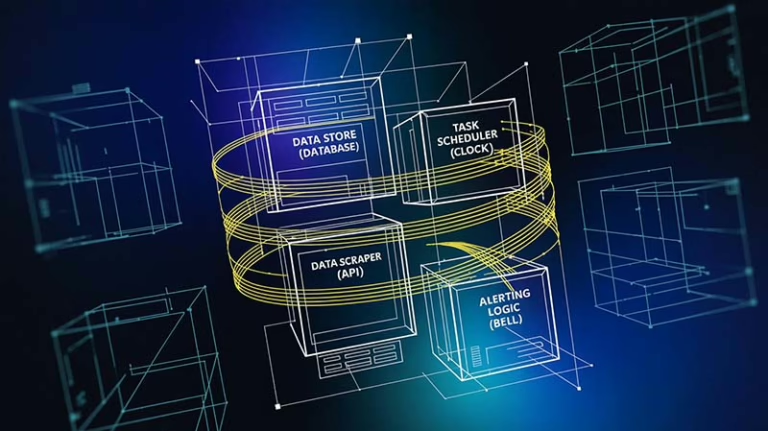

第一章:蓝图先行:产品监控系统的架构设计

在编写任何代码之前,清晰的架构设计是项目成功的基石。一个健壮的监控系统,可以拆解为以下四个核心组件:

- 数据存储 (Data Store): 这是系统的记忆核心。我们需要一个地方来持久化我们关心的商品列表,并记录下每一次采集到的历史数据。关系型数据库如

PostgreSQL或MySQL是绝佳选择。 - 任务调度器 (Scheduler): 监控任务需要被周期性地自动执行(例如,每小时执行一次)。简单的场景下,Linux的

cron就能胜任;而对于更复杂的、需要高可用性的系统,Celery Beat或APScheduler等专业的定时任务框架则更为合适。 - 数据采集模块 (Data Scraper): 这是整个系统中最复杂、也最脆弱的一环。它的唯一职责就是:根据给定的商品ASIN,可靠地从亚马逊获取到最新的、准确的商品数据(价格、库存等)。实现这个模块有两种路径:完全自研,或使用第三方数据采集API。

- 变更检测与通知逻辑 (Change Detection & Alerting): 当采集到新数据后,该模块负责将其与数据库中存储的上一版数据进行比对。如果发现关键字段(如价格)发生变化,它将触发通知机制(如发送邮件、Slack消息或调用另一个API)。

第二章:奠定基石:数据库与任务调度的实现

让我们用代码来将蓝图变为现实。

1. 数据库表结构设计

我们需要至少两张表:一张用于存储需要监控的商品,另一张用于记录价格历史。

商品表 (products_to_monitor)

SQL

CREATE TABLE products_to_monitor (

id SERIAL PRIMARY KEY,

asin VARCHAR(20) UNIQUE NOT NULL,

url TEXT NOT NULL,

last_known_price DECIMAL(10, 2),

last_checked_at TIMESTAMP WITH TIME ZONE,

is_active BOOLEAN DEFAULT TRUE,

created_at TIMESTAMP WITH TIME ZONE DEFAULT NOW()

);

价格历史表 (price_history)

SQL

CREATE TABLE price_history (

id SERIAL PRIMARY KEY,

product_id INTEGER REFERENCES products_to_monitor(id),

price DECIMAL(10, 2) NOT NULL,

scraped_at TIMESTAMP WITH TIME ZONE DEFAULT NOW()

);

2. 任务调度器实现 (以Python APScheduler为例)

APScheduler 是一个轻量级且强大的Python定时任务库,非常适合在应用内部启动周期性任务。

Python

# scheduler_setup.py

from apscheduler.schedulers.blocking import BlockingScheduler

import time

def my_monitoring_task():

"""

这是一个伪任务,代表了我们希望周期性执行的监控主逻辑。

"""

print(f"监控任务正在执行... 时间: {time.ctime()}")

# 在这里,我们将调用数据采集和变更检测的逻辑

# run_monitoring_logic()

# 创建一个调度器实例

scheduler = BlockingScheduler()

# 添加一个任务,设定为每小时执行一次 my_monitoring_task 函数

scheduler.add_job(my_monitoring_task, 'interval', hours=1, id='amazon_monitor_job')

print("调度器已启动,将每小时执行一次监控任务。按 Ctrl+C 退出。")

try:

scheduler.start()

except (KeyboardInterrupt, SystemExit):

pass

通过以上代码,我们已经搭建好了系统的“骨架”——它知道要存什么数据,也知道要“每小时”做点什么。现在,我们需要填充最核心的血肉:数据采集。

第三章:攻克难关:数据采集模块的两种实现路径

如前所述,这是最困难的部分。让我们来探讨两种实现方式。

路径A:完全自研 (The Full DIY Path)

选择这条路,意味着您将直面我们在上一篇文章中详细讨论过的所有挑战:

- 反爬虫对抗: 您需要自己采购和管理庞大的住宅IP代理池,对接验证码打码平台,并精细地模拟浏览器指纹来避免被封锁。

- 页面解析与维护: 您需要为亚马逊上不同类型的页面编写复杂的解析逻辑(Parser),并时刻准备着,因为亚马逊随时可能更新前端代码,导致您的解析规则全部失效,需要紧急修复。

- JS渲染处理: 对于大量使用JavaScript动态加载内容的页面,您必须引入Selenium或Playwright等无头浏览器技术,这会极大地增加服务器资源消耗和系统复杂度。

结论: 完全自研能让您完全掌控所有细节,但它是一个无底洞式的研发投入,需要一个专业的团队来持续维护。

路径B:专业数据采集API (The Smart Shortcut)

这条路径的思路是:将最脏最累的“数据获取”工作外包出去,让我们能专注于更有价值的“数据应用”。

与其自己搭建庞大的爬虫集群,不如调用一个专业的Scrape API。它将IP代理、验证码破解、浏览器渲染、页面解析等所有难题都在云端解决,并以一个干净、简单的API接口,向您提供稳定、可靠的结构化数据。

以下是如何在我们的监控系统中集成Pangolin Scrape API来替代自研爬虫的示例:

Python

# data_acquirer.py

import requests

import os

# 从环境变量或配置文件中读取API密钥,更安全

API_TOKEN = os.getenv("PANGOLIN_API_TOKEN")

API_BASE_URL = "http://scrapeapi.pangolinfo.com/api/v1"

def get_product_data_with_scrapeapi(asin: str, zipcode: str = "10041") -> dict:

"""

使用Pangolin Scrape API获取单个ASIN的商品数据。

"""

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_TOKEN}"

}

payload = {

"url": f"https://www.amazon.com/dp/{asin}",

"formats": ["json"],

"parserName": "amzProductDetail", # 使用预设的亚马逊商品详情解析器

"bizContext": {

"zipcode": zipcode

}

}

try:

response = requests.post(API_BASE_URL, headers=headers, json=payload, timeout=60)

response.raise_for_status()

api_response = response.json()

if api_response.get("code") == 0:

# 假设解析后的JSON数据在 data['json'][0] 中

# 注意:根据实际API返回结构,可能需要调整这里的解析路径

parsed_data = api_response.get("data", {}).get("json", [None])[0]

if parsed_data:

return parsed_data

else:

print(f"API成功返回,但未能解析出JSON数据 for ASIN: {asin}")

return None

else:

print(f"API调用出错 for ASIN {asin}: {api_response.get('message')}")

return None

except requests.exceptions.RequestException as e:

print(f"请求API时发生网络错误 for ASIN {asin}: {e}")

return None

有了这个get_product_data_with_scrapeapi函数,我们的数据采集模块就变得极其简单、稳定和强大。

第四章:整合与实现:完整的监控逻辑

现在,我们将所有组件整合在一起,构建出监控系统的核心逻辑。我们将修改第二章的调度器代码,使其真正地执行监控任务。

Python

# main_monitor.py

from apscheduler.schedulers.blocking import BlockingScheduler

from data_acquirer import get_product_data_with_scrapeapi # 导入我们的数据采集函数

import database_connector # 假设这是一个您自己编写的,用于连接和操作数据库的模块

def main_monitoring_task():

print("开始执行主监控任务...")

# 1. 从数据库获取所有需要监控的活跃商品ASIN

products = database_connector.get_active_products()

for product in products:

asin = product['asin']

last_price = product['last_known_price']

print(f"正在检查 ASIN: {asin}...")

# 2. 使用Scrape API获取最新商品数据

current_data = get_product_data_with_scrapeapi(asin)

if not current_data:

print(f"无法获取 ASIN: {asin} 的数据,跳过本次检查。")

continue

# 3. 变更检测:对比价格

# 注意:current_data['price']中的字段名需要与API返回的JSON结构一致

current_price = current_data.get('price')

if current_price and current_price != last_price:

print(f"!!! 价格变动警报 for ASIN: {asin} !!!")

print(f"旧价格: {last_price}, 新价格: {current_price}")

# 4. 触发通知 (这里仅做打印,实际应用中会调用邮件/Slack等)

# send_alert(f"ASIN {asin} 价格从 {last_price} 变为 {current_price}")

# 5. 更新数据库

database_connector.update_product_price(asin, current_price)

database_connector.log_price_history(asin, current_price)

else:

print(f"ASIN: {asin} 价格未变。")

print("主监控任务执行完毕。")

# --- 调度器设置 ---

scheduler = BlockingScheduler()

scheduler.add_job(main_monitoring_task, 'interval', hours=1, id='amazon_monitor_job')

print("监控系统已启动,将每小时运行。")

scheduler.start()

至此,我们已经拥有一个功能完善的监控系统原型。它能够自动、周期性地检查商品价格,并在发现变化时采取行动。

结论:聚焦于价值,而非重复造轮

通过本文的探讨,我们清晰地看到,构建一个**Amazon产品监控API**或系统,其核心挑战在于稳定可靠的数据采集。完全自研的路径虽然可行,但它要求您投入巨大的资源去解决一系列与您核心业务无关的技术难题。

更明智的工程实践,是将复杂的系统进行解耦,把专业的事交给专业的工具。在监控系统中,将 Amazon数据采集这一最棘手、最耗费维护精力的环节,交给像 Pangolin Scrape API 这样成熟的第三方服务,能让您的团队从繁重的“造轮子”工作中解脱出来,将100%的精力投入到更有价值的监控逻辑、数据分析和业务决策上。这不仅大大降低了研发成本,更重要的是,它能让您的业务更快地从数据中获益。

如果您希望深入了解API的更多细节,可以查阅我们详尽的调用指南,开启您的高效数据监控之旅。