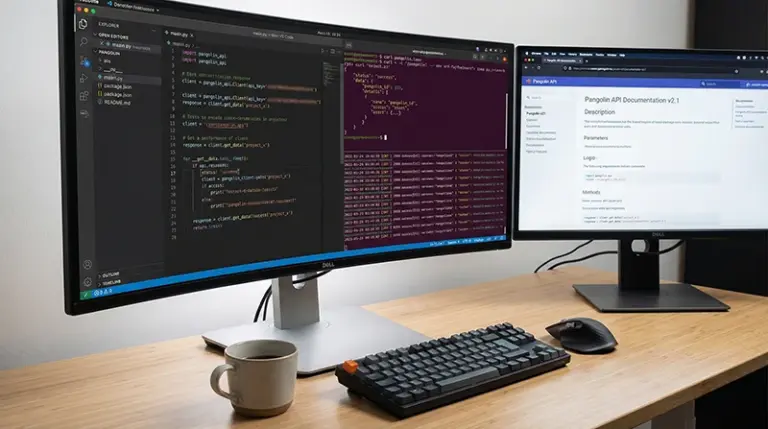

Python Pangolin API调用教程:凌晨两点,张浩盯着屏幕上密密麻麻的错误日志,额头渗出细密的汗珠。他花了整整三天时间搭建的爬虫系统,刚运行不到两小时就被亚马逊的反爬机制封禁了IP。更糟糕的是,老板明天就要看到竞品价格监控的数据报告。这不是他第一次遭遇这种困境——自建爬虫的不稳定性、维护成本的居高不下、技术门槛的持续攀升,让他开始重新思考数据采集的技术路线。

直到他接触到Pangolin Scrape API,才发现原来Python调用Pangolin API可以如此简单高效。本Python Pangolin API调用教程将通过15+完整代码示例,展示如何用几十行代码就能实现之前数千行爬虫才能完成的功能,而且稳定性和数据质量远超预期。这种转变不仅解放了技术资源,更让团队能够专注于数据分析和业务逻辑,而非疲于应付基础设施的维护。

Python Pangolin API调用教程:为什么选择API而非自建爬虫

在电商数据采集领域,开发者面临着一个经典的技术决策:是投入资源自建爬虫系统,还是集成成熟的API服务?这个问题的答案并不绝对,但对于大多数场景而言,API方案展现出明显的优势。自建爬虫看似拥有完全的控制权和灵活性,实际上却隐藏着巨大的隐性成本——你需要持续跟进目标网站的页面结构变化、应对日益复杂的反爬虫策略、维护代理IP池的质量、处理各种异常情况,这些工作往往会消耗掉团队大量的精力。

更关键的是时效性和规模化的挑战。当你需要每小时采集数万个ASIN的数据时,自建方案的网络资源成本会急剧上升;当亚马逊突然调整页面结构导致解析失败时,你可能需要紧急加班修复代码。而专业的API服务已经将这些问题系统化解决——Pangolin Scrape API能够支撑上千万页面每天的采集规模,时效性达到分钟级,对于各类亚马逊网页都积累了成熟的采集经验和解析模板。

从开发效率的角度看,API集成让你能够快速验证业务假设。与其花费数周搭建爬虫基础设施,不如用几天时间完成API对接并立即获取数据,将精力投入到真正产生价值的数据分析和应用开发中。这种敏捷性在快速变化的电商环境中尤为重要——市场机会稍纵即逝,技术实现的速度往往决定了商业竞争的胜负。

Python Pangolin API调用教程第一步:环境配置与依赖安装

开始之前,我们需要确保Python开发环境已经就绪。虽然Pangolin API支持任何能发起HTTP请求的编程语言,但Python凭借其简洁的语法、丰富的第三方库生态以及在数据处理领域的广泛应用,成为了最理想的选择。推荐使用Python 3.8或更高版本,这些版本在性能和标准库功能上都有显著提升。

环境搭建的第一步是安装必要的依赖包。我们主要需要requests库来处理HTTP请求,以及一些辅助库用于数据处理和存储。打开终端执行以下命令即可完成安装:

pip install requests pandas python-dotenv schedule这里的requests是HTTP客户端库,pandas用于数据处理和分析,python-dotenv帮助我们安全地管理API密钥等敏感信息,schedule则可以实现定时任务调度。安装完成后,建议创建一个独立的项目目录,并在其中建立清晰的文件结构——将API调用逻辑、数据处理模块、配置文件分离,这样能够提高代码的可维护性。

接下来创建一个.env文件来存储API密钥,这是一个重要的安全实践。永远不要将密钥硬编码在代码中或提交到版本控制系统,而应该通过环境变量的方式管理。在项目根目录创建.env文件并添加你的API凭证:

PANGOLIN_API_KEY=your_api_key_here

PANGOLIN_BASE_URL=https://api.pangolinfo.com/scrapeAPI认证方式:安全高效的接入

Pangolin API采用基于密钥的认证机制,这种方式既保证了安全性又不会增加开发复杂度。每次API调用时,你需要在请求参数或请求头中携带API密钥,服务端会验证密钥的有效性并返回相应数据。与OAuth等复杂的认证流程相比,这种方式对于服务端到服务端的调用场景更加直接高效。

让我们创建一个基础的API客户端类,封装认证逻辑和通用的请求处理。这种面向对象的设计能够让后续的功能扩展更加优雅:

import os

import requests

from dotenv import load_dotenv

from typing import Dict, Optional, Any

class PangolinClient:

"""Pangolin API客户端基础类"""

def __init__(self):

load_dotenv()

self.api_key = os.getenv('PANGOLIN_API_KEY')

self.base_url = os.getenv('PANGOLIN_BASE_URL')

if not self.api_key:

raise ValueError("API密钥未配置,请检查.env文件")

def _make_request(self, endpoint: str, params: Dict[str, Any]) -> Optional[Dict]:

"""发起API请求的通用方法"""

params['api_key'] = self.api_key

try:

response = requests.get(

f"{self.base_url}/{endpoint}",

params=params,

timeout=30

)

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

print(f"API请求失败: {str(e)}")

return None这个基础客户端类实现了几个关键功能:从环境变量加载配置确保了安全性,统一的请求方法简化了后续的API调用,异常捕获机制提高了程序的健壮性。在实际应用中,你可能还需要添加重试逻辑、请求日志记录、响应缓存等增强功能,但这个基础框架已经足够支撑大部分场景。

Python调用Pangolin API完整示例:获取商品详情数据

现在让我们实现第一个实战功能——获取亚马逊商品的详细信息。这是最常见的数据采集需求,也是理解API工作机制的最佳入口。Pangolin API支持通过ASIN直接获取商品的全量数据,包括标题、价格、评分、库存状态、变体信息等几十个字段。

在PangolinClient类中添加获取商品详情的方法:

def get_product_details(self, asin: str, marketplace: str = 'US') -> Optional[Dict]:

"""获取商品详情数据

Args:

asin: 亚马逊商品ASIN码

marketplace: 站点代码,如US/UK/DE等

Returns:

包含商品详细信息的字典,失败返回None

"""

params = {

'type': 'product',

'asin': asin,

'marketplace': marketplace,

'parse': 'true' # 返回解析后的结构化数据

}

return self._make_request('', params)使用这个方法非常简单,只需要几行代码就能获取完整的商品数据:

client = PangolinClient()

product_data = client.get_product_details('B08N5WRWNW')

if product_data:

print(f"商品标题: {product_data.get('title')}")

print(f"当前价格: {product_data.get('price', {}).get('value')}")

print(f"评分: {product_data.get('rating')}")

print(f"评论数: {product_data.get('reviews_total')}")返回的数据是经过解析的JSON格式,结构清晰易于处理。你可以直接提取需要的字段进行分析,也可以将整个数据对象存储到数据库中供后续使用。相比于自己编写HTML解析代码,这种方式不仅开发效率高,而且不用担心页面结构变化导致的解析失败。

错误处理方案:构建健壮的系统

在生产环境中,任何外部API调用都可能遇到各种异常情况——网络波动、服务暂时不可用、请求参数错误、配额限制等。一个成熟的集成方案必须妥善处理这些场景,而不是简单地让程序崩溃或返回错误。让我们为API客户端添加完善的错误处理和重试机制。

首先定义一些自定义异常类,用于区分不同类型的错误:

class PangolinAPIError(Exception):

"""API调用基础异常"""

pass

class AuthenticationError(PangolinAPIError):

"""认证失败异常"""

pass

class RateLimitError(PangolinAPIError):

"""请求频率超限异常"""

pass

class InvalidParameterError(PangolinAPIError):

"""参数错误异常"""

pass然后改进_make_request方法,加入详细的错误处理和智能重试逻辑:

import time

from typing import Dict, Optional, Any

def _make_request(self, endpoint: str, params: Dict[str, Any],

max_retries: int = 3) -> Optional[Dict]:

"""发起API请求,包含重试机制"""

params['api_key'] = self.api_key

for attempt in range(max_retries):

try:

response = requests.get(

f"{self.base_url}/{endpoint}",

params=params,

timeout=30

)

# 根据HTTP状态码处理不同情况

if response.status_code == 200:

return response.json()

elif response.status_code == 401:

raise AuthenticationError("API密钥无效或已过期")

elif response.status_code == 429:

# 请求频率超限,等待后重试

wait_time = int(response.headers.get('Retry-After', 60))

print(f"请求频率超限,等待{wait_time}秒后重试...")

time.sleep(wait_time)

continue

elif response.status_code == 400:

error_msg = response.json().get('message', '参数错误')

raise InvalidParameterError(f"请求参数有误: {error_msg}")

else:

response.raise_for_status()

except requests.exceptions.Timeout:

print(f"请求超时,第{attempt + 1}次重试...")

if attempt < max_retries - 1:

time.sleep(2 ** attempt) # 指数退避

continue

else:

raise PangolinAPIError("请求超时,已达最大重试次数")

except requests.exceptions.ConnectionError:

print(f"网络连接失败,第{attempt + 1}次重试...")

if attempt < max_retries - 1:

time.sleep(2 ** attempt)

continue

else:

raise PangolinAPIError("网络连接失败,已达最大重试次数")

return None这个增强版的请求方法实现了多层防护:对于临时性的网络问题采用指数退避策略自动重试,对于配额限制会遵守服务端返回的等待时间,对于明确的错误则抛出具体的异常类型便于上层处理。这种设计让你的应用能够优雅地应对各种异常场景,大幅提升系统的可靠性。

实战项目一:亚马逊榜单监控系统

理解了基础调用方法后,让我们构建第一个完整的实战项目——Best Sellers榜单监控系统。这个系统能够定时采集指定类目的热卖榜单数据,追踪榜单变化趋势,识别新上榜产品和排名波动异常的商品。对于选品和竞品分析而言,这是极具价值的数据来源。

首先扩展PangolinClient类,添加获取榜单数据的方法:

def get_bestsellers(self, category: str, marketplace: str = 'US',

page: int = 1) -> Optional[Dict]:

"""获取Best Sellers榜单数据

Args:

category: 类目URL或类目ID

marketplace: 站点代码

page: 页码

Returns:

榜单数据字典

"""

params = {

'type': 'bestsellers',

'category': category,

'marketplace': marketplace,

'page': page,

'parse': 'true'

}

return self._make_request('', params)接下来创建榜单监控类,实现数据采集、存储和变化分析的完整逻辑:

import pandas as pd

from datetime import datetime

import json

class BestSellersMonitor:

"""Best Sellers榜单监控器"""

def __init__(self, client: PangolinClient):

self.client = client

self.history_file = 'bestsellers_history.json'

self.load_history()

def load_history(self):

"""加载历史数据"""

try:

with open(self.history_file, 'r', encoding='utf-8') as f:

self.history = json.load(f)

except FileNotFoundError:

self.history = {}

def save_history(self):

"""保存历史数据"""

with open(self.history_file, 'w', encoding='utf-8') as f:

json.dump(self.history, f, ensure_ascii=False, indent=2)

def monitor_category(self, category: str, marketplace: str = 'US'):

"""监控指定类目的榜单"""

print(f"开始采集 {category} 类目的Best Sellers榜单...")

data = self.client.get_bestsellers(category, marketplace)

if not data:

print("数据采集失败")

return

timestamp = datetime.now().isoformat()

products = data.get('products', [])

# 提取关键信息

current_ranking = {}

for product in products:

asin = product.get('asin')

current_ranking[asin] = {

'rank': product.get('rank'),

'title': product.get('title'),

'price': product.get('price', {}).get('value'),

'rating': product.get('rating'),

'reviews': product.get('reviews_count'),

'timestamp': timestamp

}

# 对比历史数据,识别变化

category_key = f"{marketplace}_{category}"

if category_key in self.history:

self.analyze_changes(category_key, current_ranking)

# 更新历史记录

self.history[category_key] = current_ranking

self.save_history()

print(f"成功采集 {len(products)} 个商品数据")

def analyze_changes(self, category_key: str, current_ranking: Dict):

"""分析榜单变化"""

previous = self.history[category_key]

# 识别新上榜商品

new_products = set(current_ranking.keys()) - set(previous.keys())

if new_products:

print(f"\n发现 {len(new_products)} 个新上榜商品:")

for asin in new_products:

product = current_ranking[asin]

print(f" - {product['title'][:50]}... (排名: {product['rank']})")

# 识别排名大幅变化的商品

print("\n排名显著变化的商品:")

for asin in set(current_ranking.keys()) & set(previous.keys()):

old_rank = previous[asin]['rank']

new_rank = current_ranking[asin]['rank']

rank_change = old_rank - new_rank

if abs(rank_change) >= 10: # 排名变化超过10位

direction = "上升" if rank_change > 0 else "下降"

print(f" - {current_ranking[asin]['title'][:50]}...")

print(f" 排名{direction}: {old_rank} → {new_rank} ({abs(rank_change)}位)")

def export_to_excel(self, category_key: str, filename: str):

"""导出榜单数据到Excel"""

if category_key not in self.history:

print("没有该类目的历史数据")

return

data = self.history[category_key]

df = pd.DataFrame.from_dict(data, orient='index')

df.to_excel(filename, index_label='ASIN')

print(f"数据已导出到 {filename}")使用这个监控系统非常简单,可以设置定时任务每天自动采集:

import schedule

import time

client = PangolinClient()

monitor = BestSellersMonitor(client)

# 定义监控任务

def daily_monitor():

monitor.monitor_category('kitchen', 'US')

monitor.export_to_excel('US_kitchen', f'bestsellers_{datetime.now().strftime("%Y%m%d")}.xlsx')

# 每天早上9点执行

schedule.every().day.at("09:00").do(daily_monitor)

# 也可以立即执行一次

daily_monitor()

# 保持程序运行

while True:

schedule.run_pending()

time.sleep(60)实战项目二:竞品价格追踪系统

价格监控是电商运营中最常见也最关键的需求之一。通过持续追踪竞品的价格变化,你可以及时调整自己的定价策略、捕捉促销机会、分析竞争对手的运营节奏。让我们构建一个功能完善的价格追踪系统。

class PriceTracker:

"""竞品价格追踪器"""

def __init__(self, client: PangolinClient):

self.client = client

self.db_file = 'price_history.db'

self.init_database()

def init_database(self):

"""初始化SQLite数据库"""

import sqlite3

conn = sqlite3.connect(self.db_file)

cursor = conn.cursor()

cursor.execute('''

CREATE TABLE IF NOT EXISTS price_records (

id INTEGER PRIMARY KEY AUTOINCREMENT,

asin TEXT NOT NULL,

marketplace TEXT NOT NULL,

price REAL,

currency TEXT,

availability TEXT,

timestamp DATETIME DEFAULT CURRENT_TIMESTAMP,

INDEX idx_asin_time (asin, timestamp)

)

''')

conn.commit()

conn.close()

def track_product(self, asin: str, marketplace: str = 'US'):

"""追踪单个商品价格"""

import sqlite3

product_data = self.client.get_product_details(asin, marketplace)

if not product_data:

return False

price_info = product_data.get('price', {})

conn = sqlite3.connect(self.db_file)

cursor = conn.cursor()

cursor.execute('''

INSERT INTO price_records (asin, marketplace, price, currency, availability)

VALUES (?, ?, ?, ?, ?)

''', (

asin,

marketplace,

price_info.get('value'),

price_info.get('currency'),

product_data.get('availability')

))

conn.commit()

conn.close()

return True

def track_multiple(self, asin_list: list, marketplace: str = 'US'):

"""批量追踪多个商品"""

success_count = 0

for asin in asin_list:

if self.track_product(asin, marketplace):

success_count += 1

print(f"✓ {asin} 价格已记录")

else:

print(f"✗ {asin} 采集失败")

time.sleep(1) # 避免请求过快

print(f"\n完成: {success_count}/{len(asin_list)} 个商品")

def get_price_history(self, asin: str, days: int = 30) -> pd.DataFrame:

"""获取商品的价格历史"""

import sqlite3

conn = sqlite3.connect(self.db_file)

query = '''

SELECT timestamp, price, availability

FROM price_records

WHERE asin = ?

AND timestamp >= datetime('now', '-{} days')

ORDER BY timestamp

'''.format(days)

df = pd.read_sql_query(query, conn, params=(asin,))

conn.close()

return df

def detect_price_changes(self, asin: str, threshold: float = 0.05):

"""检测价格异常变化"""

df = self.get_price_history(asin, days=7)

if len(df) < 2:

return None

latest_price = df.iloc[-1]['price']

previous_price = df.iloc[-2]['price']

if previous_price and latest_price:

change_rate = (latest_price - previous_price) / previous_price

if abs(change_rate) >= threshold:

return {

'asin': asin,

'previous_price': previous_price,

'current_price': latest_price,

'change_rate': change_rate,

'alert_type': 'price_drop' if change_rate < 0 else 'price_increase'

}

return None

def generate_report(self, asin_list: list):

"""生成价格监控报告"""

alerts = []

for asin in asin_list:

alert = self.detect_price_changes(asin)

if alert:

alerts.append(alert)

if alerts:

print("\n=== 价格异动预警 ===")

for alert in alerts:

change_pct = alert['change_rate'] * 100

symbol = "↓" if alert['alert_type'] == 'price_drop' else "↑"

print(f"{symbol} {alert['asin']}: "

f"${alert['previous_price']:.2f} → ${alert['current_price']:.2f} "

f"({change_pct:+.1f}%)")

else:

print("未检测到显著价格变化")

return alerts这个价格追踪系统使用SQLite数据库存储历史数据,支持批量监控、价格变化检测和报告生成。实际使用时可以这样配置:

# 初始化追踪器

tracker = PriceTracker(client)

# 定义竞品ASIN列表

competitor_asins = [

'B08N5WRWNW',

'B07XJ8C8F5',

'B09B8RWTK3'

]

# 每小时执行一次价格采集

def hourly_price_check():

tracker.track_multiple(competitor_asins)

tracker.generate_report(competitor_asins)

schedule.every().hour.do(hourly_price_check)高级技巧:数据采集的优化策略

当你的监控规模扩大到数百甚至数千个ASIN时,如何优化采集效率和成本就成为关键问题。首先是请求的批量化处理——虽然API通常是单个请求单个响应,但你可以在应用层实现并发控制,使用Python的concurrent.futures模块同时发起多个请求,显著提升吞吐量。

from concurrent.futures import ThreadPoolExecutor, as_completed

def batch_fetch_products(client: PangolinClient, asin_list: list, max_workers: int = 5):

"""并发批量获取商品数据"""

results = {}

with ThreadPoolExecutor(max_workers=max_workers) as executor:

# 提交所有任务

future_to_asin = {

executor.submit(client.get_product_details, asin): asin

for asin in asin_list

}

# 收集结果

for future in as_completed(future_to_asin):

asin = future_to_asin[future]

try:

data = future.result()

if data:

results[asin] = data

print(f"✓ {asin}")

except Exception as e:

print(f"✗ {asin}: {str(e)}")

return results另一个优化方向是智能缓存机制。对于变化频率较低的数据,比如商品的基础信息,没有必要每次都实时采集。可以设置缓存有效期,在有效期内直接返回缓存数据:

import pickle

from datetime import datetime, timedelta

class CachedPangolinClient(PangolinClient):

"""带缓存功能的API客户端"""

def __init__(self, cache_ttl: int = 3600):

super().__init__()

self.cache = {}

self.cache_ttl = cache_ttl # 缓存有效期(秒)

def get_product_details(self, asin: str, marketplace: str = 'US',

use_cache: bool = True) -> Optional[Dict]:

"""获取商品详情,支持缓存"""

cache_key = f"{marketplace}_{asin}"

# 检查缓存

if use_cache and cache_key in self.cache:

cached_data, cached_time = self.cache[cache_key]

if datetime.now() - cached_time < timedelta(seconds=self.cache_ttl):

print(f"从缓存返回 {asin}")

return cached_data

# 调用API获取新数据

data = super().get_product_details(asin, marketplace)

# 更新缓存

if data:

self.cache[cache_key] = (data, datetime.now())

return data从API到无代码:降低技术门槛

虽然Python调用API已经大幅简化了数据采集的复杂度,但对于没有编程背景的运营人员来说,仍然存在一定的技术门槛。这就是为什么Pangolin还提供了AMZ Data Tracker这样的可视化配置工具——它允许用户通过界面操作完成数据采集任务的配置,无需编写一行代码。

AMZ Data Tracker支持按关键词、ASIN、店铺、榜单、类目等多种方式进行采集,并且可以将采集的数据直接生成自定义的Excel表格,可直接用于运营分析。对于需要快速验证想法或者技术资源有限的团队,这种零代码方案提供了另一种可能性。

当然,API方案和可视化工具并不是互斥的选择。很多团队采用混合策略——运营人员使用AMZ Data Tracker进行日常的数据查询和报表生成,技术团队则通过API实现更复杂的自动化流程和深度数据分析。这种分工让每个角色都能使用最适合自己的工具,最大化整体效率。

实时数据抓取:监控系统的核心能力

无论是榜单监控还是价格追踪,所有监控系统的基础都是定期的实时数据抓取。数据的时效性直接决定了监控的价值——过时的价格信息可能导致错误的定价决策,延迟的榜单数据会让你错过市场趋势的早期信号。这就是为什么选择一个能够提供分钟级数据更新的API服务如此重要。

Pangolin Scrape API在这方面展现出明显的技术优势。它不仅能够支撑上千万页面每天的采集规模,更重要的是保证了数据的准确性和完整性。对于亚马逊的各类页面,Pangolin都积累了成熟的采集经验和解析模板——从商品详情页的product description字段,到customer says中的全部评论热词及情感倾向,再到sponsored广告位高达98%的采集率,这些都是自建爬虫难以达到的水平。

特别是对于广告数据的采集,由于亚马逊的sponsored广告位是一个黑箱算法,要达到高采集率需要非常强的综合能力。而如果采集率较低,会直接导致对关键词流量来源的分析不准确,进而影响广告投放策略的制定。专业的API服务通过持续的技术投入解决了这些难题,让开发者可以专注于数据的应用而非采集本身。

从数据到洞察:构建完整的分析链路

采集到数据只是第一步,如何将原始数据转化为业务洞察才是核心价值所在。建议建立一个分层的数据处理架构:原始数据层负责存储API返回的完整JSON数据,清洗层进行数据标准化和质量检查,聚合层按照业务维度进行汇总统计,应用层则基于聚合数据生成各类报表和预警。

在实际应用中,可以将采集到的数据导入到数据分析工具中进行深度挖掘。比如使用pandas进行时间序列分析,识别价格波动的周期性规律;使用机器学习模型预测榜单排名的变化趋势;或者构建竞品画像,从多个维度评估竞争对手的运营策略。这些高级分析能力的前提是拥有高质量、持续更新的数据源。

另一个重要的应用方向是将监控数据与自身的运营数据结合分析。单独看竞品的价格变化可能只是一个信号,但如果同时发现自己的流量在下降、转化率在降低,就需要立即做出响应。这种关联分析需要打通不同的数据源,这也是为什么越来越多的团队选择基于API构建自己的数据中台,实现从采集到应用的全链路整合。

写在最后:技术赋能业务增长

回到文章开头张浩的故事,当他从自建爬虫转向API集成后,不仅解决了系统稳定性的问题,更重要的是释放了团队的创造力。原本花在维护爬虫基础设施上的时间,现在可以投入到数据分析模型的优化、业务逻辑的创新上。这种转变带来的不仅是效率提升,更是思维方式的转变——从关注技术实现细节,到聚焦业务价值创造。

Python调用Pangolin API的完整实践证明,选择合适的技术方案能够显著降低开发成本、缩短上线周期、提高系统可靠性。无论你是刚开始接触电商数据采集的开发者,还是希望优化现有系统的技术负责人,API集成都值得认真考虑。它代表了一种更加专业化、更加高效的技术路径——让专业的服务做专业的事,而你则专注于创造独特的业务价值。

从今天开始,尝试用本文提供的代码示例构建你的第一个监控系统。从简单的商品详情获取开始,逐步扩展到榜单监控、价格追踪,最终建立起完整的竞品情报体系。技术的价值在于应用,而数据的价值在于洞察。当你掌握了这些工具和方法,你就拥有了在电商竞争中脱颖而出的技术优势。

相关资源

- 📖 Pangolin API 完整用户指南 – 官方技术文档

- 🌐 Pangolin 官方网站 – 了解更多产品信息

- 💡 API 定价方案 – 选择适合您的套餐

- 🚀 免费试用 – 立即开始您的数据采集之旅