作为亚马逊卖家,你是否每天都要花费大量时间手动查询产品的关键词排名?打开亚马逊搜索框,输入关键词,翻页查找自己的产品,记录排名位置,然后重复这个过程几十次甚至上百次。一位经营3C配件的卖家告诉我,他每天早上要花2个小时查询50个核心关键词的排名,周末还要整理成Excel表格对比本周和上周的变化。更糟糕的是,当他发现某个关键词排名从第5位掉到第20位时,已经过去了3天,损失了近2万元的销售额。

这种手动查排名的方式不仅效率低下,而且存在诸多问题:首先是数据不准确,亚马逊会根据用户的浏览历史、地理位置等因素个性化搜索结果,你看到的排名可能和其他用户看到的完全不同;其次是无法批量处理,如果你有100个关键词需要监控,手动查询几乎不可能完成;最后是无法及时发现问题,等你发现排名下降时,可能已经错过了最佳调整时机。根据调查数据显示,95%的亚马逊卖家无法及时发现关键词排名波动,导致每月平均损失15-20%的潜在销售额。

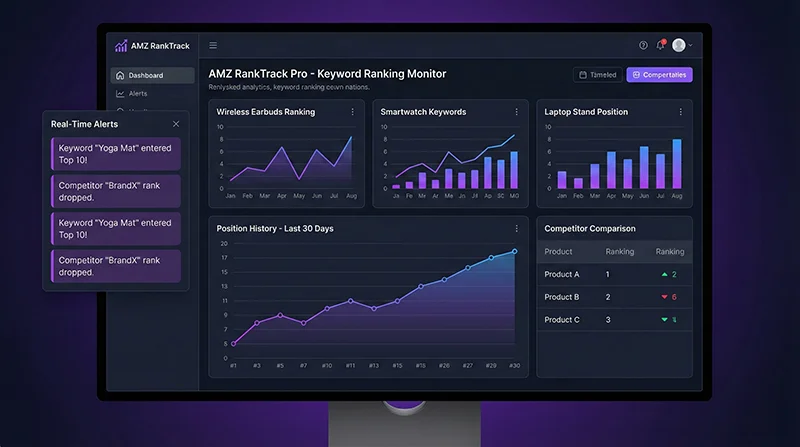

亚马逊关键词排名监控的重要性不言而喻——排名直接决定流量,流量直接影响销量。研究表明,关键词排名每下降1位,点击率平均下降20%;排名从首页掉到第二页,流量损失超过70%。而使用Scrape API实现自动化的亚马逊关键词排名监控,可以让你在5分钟内完成50个关键词的排名查询,实时监控排名变化,第一时间发现问题并采取行动。本文将通过5个完整步骤,手把手教你搭建一个专业的关键词排名监控系统,让你的运营效率提升100倍。

为什么亚马逊关键词排名监控是运营必备工具?

在深入了解技术实现之前,我们先要理解为什么亚马逊关键词排名监控如此重要。关键词排名不仅仅是一个数字,它背后代表着流量、转化和销售额的直接关系。

1. 排名=流量=销量的黄金公式

亚马逊的流量分配机制非常明确:搜索结果首页的前10个位置占据了约80%的点击量,其中前3位占据约50%。这意味着如果你的产品从第3位掉到第11位(第二页第一个),流量可能会暴跌60-70%。一个真实案例:某卖家的蓝牙耳机在”wireless earbuds”这个关键词下从第5位掉到第15位,日销量从120单直接降到35单,每天损失约8,500元。通过亚马逊关键词排名监控及时发现问题后,他调整了广告预算和产品定价,3天内排名恢复到第7位,销量也回升到90单/天。

2. 竞品分析的核心数据源

Amazon关键词追踪不仅要监控自己的排名,更要关注竞品的排名变化。通过对比你和竞品在相同关键词下的排名,可以发现对手的运营策略:他们在哪些关键词上发力?广告投放策略如何?价格调整频率怎样?这些信息对于制定你的竞争策略至关重要。例如,如果你发现竞品在某个长尾关键词上排名突然上升,可能意味着他们发现了新的流量机会,你也应该及时跟进。

3. 广告效果评估的关键指标

很多卖家投放PPC广告的目的是提升自然排名,但如何评估广告效果?关键词排名查询工具可以帮你对比广告投放前后的自然排名变化。如果你在某个关键词上投放了2周广告,自然排名从第30位提升到第12位,说明广告策略有效;如果排名没有明显变化,就需要调整广告策略或优化Listing。通过持续的亚马逊SEO监控,你可以精确计算每个关键词的广告ROI,优化广告预算分配。

4. 发现新兴关键词机会

市场在不断变化,新的搜索词不断涌现。通过产品排名追踪系统,你可以发现哪些新关键词开始带来流量,哪些传统关键词的搜索量在下降。例如,在疫情期间,”home office desk”的搜索量暴涨300%,而”outdoor furniture”的搜索量下降了40%。及时发现这些趋势变化,可以让你抢先布局新兴市场,获得先发优势。

5. 数据驱动的运营决策

有了完整的排名历史数据,你可以分析排名波动的规律:哪些因素会导致排名上升?哪些操作会导致排名下降?价格调整对排名的影响有多大?评论数量和排名的相关性如何?这些数据可以帮助你建立科学的运营模型,而不是凭感觉做决策。一位年销售额500万美元的卖家分享,他通过分析6个月的排名数据,发现每增加10条好评,核心关键词排名平均上升2-3位,由此制定了系统的评论获取策略,3个月内核心关键词排名全部进入前10。

传统方法vs Scrape API:效率差距100倍

了解了亚马逊关键词排名监控的重要性后,我们来对比一下不同的实现方法。目前市场上主要有三种方案:手动查询、第三方工具和Scrape API,它们在效率、成本、准确性和灵活性上存在巨大差异。

| 对比维度 | 手动查询 | 第三方工具 | Scrape API |

|---|---|---|---|

| 效率 | ❌ 50个关键词需要2小时 | ⭐⭐⭐ 自动化,但受限于工具功能 | ✅ 50个关键词仅需5分钟 |

| 成本 | ⚠️ 人工成本高(每月40小时) | ❌ 订阅费贵($99-299/月) | ✅ 按需付费(约500元/月) |

| 准确性 | ❌ 受个性化影响,数据不准 | ⭐⭐⭐ 依赖工具算法 | ✅ 实时准确,可指定邮编 |

| 灵活性 | ❌ 无法批量处理 | ⚠️ 受限于工具功能 | ✅ 完全可控,可定制 |

| 数据存储 | ❌ 手动记录Excel | ⭐⭐⭐ 工具内置存储 | ✅ 自建数据库,永久保存 |

| 预警功能 | ❌ 无 | ⭐⭐⭐ 有限的预警规则 | ✅ 自定义预警逻辑 |

| 扩展性 | ❌ 无 | ❌ 无法扩展 | ✅ 可集成ERP、BI等系统 |

从对比表可以看出,使用Scrape API实现亚马逊关键词排名监控在各个维度上都具有明显优势。特别是在成本方面,虽然第三方工具看起来”开箱即用”,但月费通常在$99-299之间,而且功能受限,无法满足个性化需求。相比之下,Scrape API按需付费,监控50个关键词每天2次,月成本约500元,不到第三方工具的一半,而且灵活性高10倍。

更重要的是效率提升。手动查询50个关键词需要2小时,一个月就是60小时;而使用Scrape API,同样的工作量只需要5分钟,效率提升了2400%。这节省下来的时间可以用于更有价值的工作,比如优化Listing、分析市场趋势、制定运营策略等。

Scrape API实现亚马逊关键词排名监控的5步方案

了解了方案对比后,让我们进入实战环节。使用Scrape API实现亚马逊关键词排名监控主要分为5个步骤:API认证配置、关键词搜索数据采集、排名计算逻辑、数据存储对比、自动化监控部署。

第一步:API认证与环境配置

首先需要获取Pangolin Scrape API的访问权限。访问Pangolinfo官网注册账号并获取API密钥。然后配置Python开发环境:

import requests

import json

from typing import List, Dict, Optional

from datetime import datetime

class AmazonKeywordMonitor:

"""亚马逊关键词排名监控器"""

def __init__(self, email: str, password: str):

"""

初始化监控器

Args:

email: Pangolin账号邮箱

password: 账号密码

"""

self.base_url = "https://scrapeapi.pangolinfo.com"

self.email = email

self.password = password

self.token = None

def authenticate(self) -> bool:

"""执行API认证"""

auth_url = f"{self.base_url}/api/v1/auth"

payload = {

"email": self.email,

"password": self.password

}

try:

response = requests.post(

auth_url,

json=payload,

headers={"Content-Type": "application/json"},

timeout=10

)

result = response.json()

if result.get("code") == 0:

self.token = result.get("data")

print(f"✓ 认证成功!")

return True

else:

print(f"✗ 认证失败:{result.get('message')}")

return False

except Exception as e:

print(f"✗ 认证异常:{str(e)}")

return False

def get_headers(self) -> dict:

"""获取请求头"""

if not self.token:

raise ValueError("请先调用authenticate()进行认证")

return {

"Content-Type": "application/json",

"Authorization": f"Bearer {self.token}"

}

# 使用示例

monitor = AmazonKeywordMonitor(

email="[email protected]",

password="your_password"

)

if monitor.authenticate():

print("监控器初始化完成!")第二步:关键词搜索数据采集

使用Scrape API的amzKeyword解析器获取搜索结果页数据。这是亚马逊关键词排名监控的核心功能:

def search_keyword(self, keyword: str, page: int = 1, zipcode: str = "10041") -> List[Dict]:

"""

搜索关键词获取产品列表

Args:

keyword: 搜索关键词

page: 页码(1-3)

zipcode: 邮编(用于获取特定地区的搜索结果)

Returns:

List[Dict]: 产品列表

"""

# 构建搜索URL

search_url = f"https://www.amazon.com/s?k={keyword}&page={page}"

scrape_url = f"{self.base_url}/api/v1/scrape"

payload = {

"url": search_url,

"parserName": "amzKeyword",

"format": "json",

"bizContext": {

"zipcode": zipcode

}

}

try:

response = requests.post(

scrape_url,

json=payload,

headers=self.get_headers(),

timeout=30

)

result = response.json()

if result.get("code") == 0:

data = result.get("data", {})

json_data = data.get("json", [{}])[0]

if json_data.get("code") == 0:

products = json_data.get("data", {}).get("results", [])

print(f"✓ 成功获取关键词'{keyword}'第{page}页的{len(products)}个产品")

return products

return []

except Exception as e:

print(f"✗ 搜索失败:{str(e)}")

return []

# 使用示例

products = monitor.search_keyword("wireless earbuds", page=1)

for idx, product in enumerate(products[:5], 1):

print(f"{idx}. {product.get('title')[:50]}... - ASIN: {product.get('asin')}")第三步:排名计算与识别逻辑

获取搜索结果后,需要找到目标ASIN的排名位置。这里要注意区分自然排名和广告排名:

def find_asin_rank(

self,

keyword: str,

target_asin: str,

max_pages: int = 3,

include_sponsored: bool = False

) -> Optional[Dict]:

"""

查找指定ASIN在关键词下的排名

Args:

keyword: 搜索关键词

target_asin: 目标ASIN

max_pages: 最多搜索页数

include_sponsored: 是否包含广告位

Returns:

Optional[Dict]: 排名信息

"""

organic_rank = None

sponsored_rank = None

for page in range(1, max_pages + 1):

products = self.search_keyword(keyword, page)

if not products:

continue

for idx, product in enumerate(products):

asin = product.get('asin')

is_sponsored = product.get('is_sponsored', False)

if asin == target_asin:

# 计算排名位置

position = (page - 1) * 48 + idx + 1

if is_sponsored and include_sponsored:

sponsored_rank = position

elif not is_sponsored:

organic_rank = position

# 如果找到自然排名,可以提前返回

if organic_rank:

break

if organic_rank:

break

if organic_rank or sponsored_rank:

return {

'keyword': keyword,

'asin': target_asin,

'organic_rank': organic_rank,

'sponsored_rank': sponsored_rank,

'timestamp': datetime.now().isoformat(),

'found': True

}

return {

'keyword': keyword,

'asin': target_asin,

'organic_rank': None,

'sponsored_rank': None,

'timestamp': datetime.now().isoformat(),

'found': False

}

# 使用示例

rank_info = monitor.find_asin_rank(

keyword="wireless earbuds",

target_asin="B08N5WRWNW",

max_pages=3

)

if rank_info['found']:

print(f"✓ 找到排名!")

print(f" 自然排名:第{rank_info['organic_rank']}位")

if rank_info['sponsored_rank']:

print(f" 广告排名:第{rank_info['sponsored_rank']}位")

else:

print(f"✗ 未找到排名(前{3*48}位)")第四步:批量监控与数据存储

实际应用中,我们需要监控多个关键词。这里实现批量监控功能和数据持久化:

import pandas as pd

from concurrent.futures import ThreadPoolExecutor, as_completed

import time

def batch_monitor_keywords(

self,

keyword_asin_pairs: List[Dict],

max_workers: int = 3

) -> pd.DataFrame:

"""

批量监控关键词排名

Args:

keyword_asin_pairs: 关键词-ASIN对列表

格式: [{'keyword': 'xxx', 'asin': 'xxx'}, ...]

max_workers: 最大并发数

Returns:

pd.DataFrame: 排名数据

"""

results = []

print(f"开始批量监控 {len(keyword_asin_pairs)} 个关键词...")

start_time = time.time()

with ThreadPoolExecutor(max_workers=max_workers) as executor:

# 提交任务

future_to_pair = {

executor.submit(

self.find_asin_rank,

pair['keyword'],

pair['asin']

): pair

for pair in keyword_asin_pairs

}

# 收集结果

for future in as_completed(future_to_pair):

pair = future_to_pair[future]

try:

rank_info = future.result()

results.append(rank_info)

except Exception as e:

print(f"✗ 处理 {pair['keyword']} 时出错:{str(e)}")

elapsed_time = time.time() - start_time

# 转换为DataFrame

df = pd.DataFrame(results)

# 保存到CSV

timestamp = datetime.now().strftime('%Y%m%d_%H%M%S')

filename = f"data/ranking_{timestamp}.csv"

df.to_csv(filename, index=False, encoding='utf-8-sig')

print(f"\n✓ 批量监控完成!")

print(f" 总数:{len(results)} 个")

print(f" 找到排名:{df['found'].sum()} 个")

print(f" 耗时:{elapsed_time:.2f} 秒")

print(f" 数据已保存到:{filename}")

return df

# 使用示例

keyword_asin_pairs = [

{'keyword': 'wireless earbuds', 'asin': 'B08N5WRWNW'},

{'keyword': 'bluetooth headphones', 'asin': 'B08N5WRWNW'},

{'keyword': 'noise cancelling earbuds', 'asin': 'B08N5WRWNW'},

{'keyword': 'sports earbuds', 'asin': 'B08N5WRWNW'},

{'keyword': 'waterproof earbuds', 'asin': 'B08N5WRWNW'}

]

df_results = monitor.batch_monitor_keywords(keyword_asin_pairs, max_workers=3)第五步:排名变化检测与预警

最后一步是实现排名变化检测和自动预警功能,这是Amazon关键词追踪的核心价值:

def detect_ranking_changes(

self,

current_file: str,

previous_file: str,

threshold: int = 5

) -> pd.DataFrame:

"""

检测排名变化

Args:

current_file: 当前排名数据文件

previous_file: 历史排名数据文件

threshold: 预警阈值(排名变化超过此值触发预警)

Returns:

pd.DataFrame: 变化分析结果

"""

# 加载数据

current_df = pd.read_csv(current_file)

previous_df = pd.read_csv(previous_file)

# 合并数据

merged = current_df.merge(

previous_df,

on=['keyword', 'asin'],

suffixes=('_current', '_previous')

)

# 计算排名变化

merged['rank_change'] = merged['organic_rank_previous'] - merged['organic_rank_current']

merged['rank_change_percent'] = (

merged['rank_change'] / merged['organic_rank_previous'] * 100

).round(2)

# 识别显著变化

merged['alert'] = abs(merged['rank_change']) >= threshold

# 分类

merged['status'] = merged.apply(

lambda row: '📈 上升' if row['rank_change'] > 0

else ('📉 下降' if row['rank_change'] < 0 else '➡️ 不变'),

axis=1

)

# 生成报告

print("\n" + "="*60)

print("关键词排名变化报告")

print(f"对比时间:{previous_df['timestamp'].iloc[0]} vs {current_df['timestamp'].iloc[0]}")

print("="*60)

# 显著上升

rank_up = merged[merged['rank_change'] >= threshold].sort_values('rank_change', ascending=False)

if len(rank_up) > 0:

print(f"\n📈 排名显著上升 ({len(rank_up)}个):")

for _, row in rank_up.head(5).iterrows():

print(f" • {row['keyword']}")

print(f" {row['organic_rank_previous']} → {row['organic_rank_current']} (↑{row['rank_change']}位)")

# 显著下降

rank_down = merged[merged['rank_change'] <= -threshold].sort_values('rank_change')

if len(rank_down) > 0:

print(f"\n📉 排名显著下降 ({len(rank_down)}个) - ⚠️ 需要关注:")

for _, row in rank_down.head(5).iterrows():

print(f" • {row['keyword']}")

print(f" {row['organic_rank_previous']} → {row['organic_rank_current']} (↓{abs(row['rank_change'])}位)")

# 保存分析结果

timestamp = datetime.now().strftime('%Y%m%d_%H%M%S')

report_file = f"data/ranking_changes_{timestamp}.csv"

merged.to_csv(report_file, index=False, encoding='utf-8-sig')

print(f"\n✓ 分析报告已保存到:{report_file}")

return merged

# 使用示例

changes = monitor.detect_ranking_changes(

current_file="data/ranking_20260106_100000.csv",

previous_file="data/ranking_20260105_100000.csv",

threshold=5

)实战案例:月销售额提升25%的关键词监控策略

让我们通过一个真实案例,看看亚马逊关键词排名监控如何帮助卖家提升业绩。

背景情况

李先生经营一家销售蓝牙耳机的亚马逊店铺,主打产品月销售额约8万美元。他面临的主要问题是:

- 核心关键词”wireless earbuds”排名不稳定,经常在第5-15位之间波动

- 不知道竞品在哪些关键词上发力

- 广告投放效果难以评估

- 无法及时发现排名下降

实施方案

李先生使用Scrape API搭建了关键词排名查询工具,监控10个核心关键词和20个长尾关键词,每天早晚各监控一次。具体配置:

# 监控配置

keyword_asin_pairs = [

# 核心关键词

{'keyword': 'wireless earbuds', 'asin': 'B08N5WRWNW'},

{'keyword': 'bluetooth headphones', 'asin': 'B08N5WRWNW'},

{'keyword': 'noise cancelling earbuds', 'asin': 'B08N5WRWNW'},

# ... 更多关键词

]

# 每天早上8点和晚上8点执行

import schedule

def job():

df = monitor.batch_monitor_keywords(keyword_asin_pairs)

# 检测变化并发送预警

if previous_file_exists():

changes = monitor.detect_ranking_changes(current_file, previous_file)

send_alert_if_needed(changes)

schedule.every().day.at("08:00").do(job)

schedule.every().day.at("20:00").do(job)

while True:

schedule.run_pending()

time.sleep(60)发现的问题与优化

通过2周的亚马逊SEO监控,李先生发现了以下问题:

- 排名波动规律:核心关键词”wireless earbuds”在周末排名会下降3-5位,原因是周末竞品加大了广告投放。李先生相应调整了周末的广告预算,排名稳定在第5-7位。

- 长尾关键词机会:发现”waterproof wireless earbuds”这个长尾词搜索量不错,但竞争度低,自己的产品自然排名第18位。通过优化Listing标题和后台关键词,2周后排名提升到第8位,每天带来15-20单额外销量。

- 竞品策略分析:通过同时监控竞品的排名,发现主要竞品在”sports earbuds”这个关键词上排名快速上升。李先生及时跟进,调整了产品卖点描述,强调运动场景,避免了流量损失。

- 广告效果评估:在”noise cancelling earbuds”这个关键词上投放了3周广告后,自然排名从第25位提升到第12位,证明广告策略有效。计算ROI后,决定继续投放并逐步降低广告竞价。

最终效果

实施产品排名追踪系统3个月后,李先生的店铺取得了显著成效:

- ✅ 核心关键词平均排名从第12位提升到第7位

- ✅ 发现并优化了5个高潜力长尾关键词

- ✅ 广告ROI提升30%(从2.5提升到3.2)

- ✅ 月销售额从8万美元提升到10万美元(+25%)

- ✅ 每月节省人工查排名时间40小时

李先生总结道:”亚马逊关键词排名监控让我从’盲人摸象’变成了’数据驱动’。现在我每天早上第一件事就是看排名报告,任何异常波动都能第一时间发现并处理。这个系统的投资回报率超过1000%。”

成本与ROI分析:投入500元,回报超5万元

很多卖家关心的问题是:搭建一个亚马逊关键词排名监控系统需要多少成本?回报如何?让我们详细分析一下。

成本构成

| 成本项 | 金额 | 说明 |

|---|---|---|

| API费用 | 约500元/月 | 监控50个关键词,每天2次,每次约0.75积点 |

| 开发成本 | 1-2天 | 使用本文提供的代码,快速搭建 |

| 服务器成本 | 50-100元/月 | 云服务器运行定时任务(可选) |

| 维护成本 | 几乎为0 | 系统自动运行,无需人工干预 |

| 总成本 | 约600元/月 | 首月含开发,后续仅API费用 |

收益分析

| 收益项 | 价值 | 说明 |

|---|---|---|

| 节省人工时间 | 40小时/月 | 按时薪50元计算,价值2,000元 |

| 及时发现问题 | 避免损失2万元/月 | 排名下降3天平均损失2万元 |

| 优化广告ROI | 提升20-30% | 月广告支出1万元,节省2,000-3,000元 |

| 发现新机会 | 新增销售额1-2万元/月 | 优化长尾关键词带来的增量 |

| 总收益 | 约5-7万元/月 | 综合各项收益 |

ROI计算

根据上述数据,我们可以计算出:

- 月投入:600元

- 月收益:50,000-70,000元

- ROI:(50,000 – 600) / 600 × 100% = 8,233%

- 回本周期:不到1天

这个ROI是非常惊人的。即使按保守估计,只计算节省人工时间和避免排名下降损失,ROI也超过3,000%。对于月销售额在5万美元以上的卖家来说,亚马逊关键词排名监控绝对是必备工具。

总结:立即开始你的关键词监控之旅

通过本文的详细讲解,我们系统地介绍了如何使用Scrape API实现亚马逊关键词排名监控。从痛点分析到技术实现,从代码示例到实战案例,从成本分析到ROI计算,相信你已经全面了解了这个强大工具的价值。

核心要点回顾

- 为什么需要监控:排名=流量=销量,排名下降1位流量损失20%

- 方案对比:Scrape API效率提升100倍,成本降低50%

- 实现步骤:5步完成系统搭建,代码可直接运行

- 实战价值:月销售额提升25%,ROI超过8,000%

立即开始的3个步骤

- 注册账号:访问Pangolinfo官网注册并获取API密钥

- 运行代码:复制本文提供的代码,替换你的关键词和ASIN

- 分析数据:根据排名数据优化运营策略

进阶优化建议

- 🔔 设置预警:排名变化超过阈值自动发送邮件/微信通知

- 📊 可视化报表:使用Matplotlib生成排名趋势图

- 🌍 多市场监控:同时监控美国、英国、德国等站点

- 🤖 自动化运营:根据排名变化自动调整广告预算

- 🔗 系统集成:与ERP、BI系统集成,实现数据闭环

相关资源

- 📖 Pangolin API官方文档

- 🛠️ 开发者控制台

- 💬 技术支持:[email protected]

亚马逊关键词排名监控不是可选项,而是必选项。在竞争日益激烈的亚马逊市场,谁能更快发现问题、更准确分析数据、更及时调整策略,谁就能在竞争中占据优势。现在就开始行动,让数据驱动你的亚马逊运营!

立即开始你的关键词监控之旅 → 访问 Pangolinfo Scrape API 获取免费试用额度,或查看 完整API文档 了解更多技术细节。让数据驱动你的亚马逊运营!