当竞品悄悄降价,你却在24小时后才发现

在亚马逊的价格战中,时间就是金钱。一位经营3C类目的资深卖家曾向我倾诉他的痛苦经历:某个周五晚上,主要竞品突然将爆款产品降价15%,而他的监控工具直到周一上午才发出提醒——整整48小时的延迟。这两天里,他损失了近300个订单,销售额下滑超过$15,000。更令人沮丧的是,当他紧急调价时,竞品已经恢复原价,而他却陷入了被动的价格战泥潭。

这绝非个例。传统的监控方式存在致命缺陷:人工巡查效率低下且容易遗漏,定时爬虫受限于采集频率无法做到真正实时,SaaS工具的黑盒机制让你无法掌控关键参数。当市场以分钟为单位快速变化时,以小时甚至天为单位的监控延迟,就像用望远镜看脚下的路——你能看到远方,却会被眼前的坑绊倒。

更深层的问题在于,大多数卖家缺乏构建自动化监控系统的能力。他们要么依赖昂贵且功能受限的第三方工具,要么投入大量人力进行低效的人工监控。而那些掌握了实时监控系统搭建技术的团队,正在用技术优势碾压对手——他们能在竞品调价后的5分钟内收到告警,10分钟内完成策略调整,始终保持市场主动权。这种信息时效性的差距,正在重新定义亚马逊运营的竞争格局。

为什么传统监控方式无法满足实时性需求?

困境一:数据采集频率与成本的矛盾

要实现真正的实时监控,理想状态是每分钟甚至每秒都采集一次数据。但这带来了巨大的技术挑战:如果你监控100个竞品ASIN,每个ASIN每分钟采集一次,一天就是14.4万次请求。传统爬虫方案在这种频率下会遇到IP封禁、验证码拦截、服务器负载过高等一系列问题。即使勉强维持运行,服务器成本、代理IP成本也会高得离谱。

更棘手的是,亚马逊的反爬虫机制在不断升级。高频访问会触发风控系统,返回的数据可能是不完整的,甚至直接返回错误页面。这就形成了一个悖论:你越想要实时数据,系统越容易被封禁;降低频率保证稳定性,又失去了实时性。大多数自建爬虫团队最终妥协在每10-30分钟采集一次,这个频率对于价格战来说,依然太慢了。

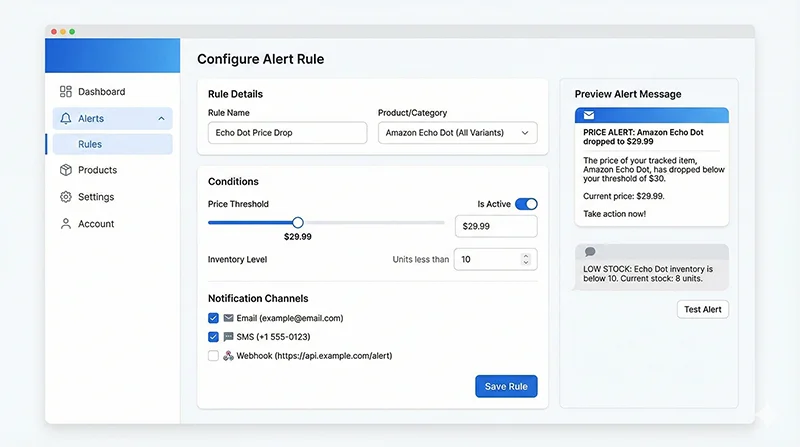

困境二:告警规则的复杂性与灵活性

简单的价格变化告警很容易实现,但实际运营中的需求要复杂得多。你可能需要这样的规则:”当竞品A的价格低于我的价格且差距超过$5时告警,但如果对方库存少于10件则忽略”;或者”当我的排名从前10掉到前20,且同时有3个以上竞品排名上升时告警”。这种多维度、多条件的复杂规则,需要一个灵活的告警引擎来支撑。

传统的监控工具往往只提供固定的几种告警模板,无法满足个性化需求。而自己从零开发告警引擎,又需要处理规则解析、条件匹配、告警去重、通知发送等一系列技术问题。很多团队在这个环节卡住了——他们能采集到数据,却无法将数据转化为有价值的告警信息。

困境三:多渠道通知的可靠性保障

告警信息的价值在于能被及时看到并采取行动。但现实中,邮件可能被归类为垃圾邮件,短信可能因为运营商问题延迟送达,App推送可能被用户关闭了通知权限。一个可靠的价格库存变化通知系统,需要支持多渠道并行发送,并且有失败重试机制。

更进一步,不同级别的告警应该用不同的通知方式。紧急告警(如竞品大幅降价)应该通过短信+电话的方式立即通知,普通告警(如评论数增加)可以通过邮件或Slack消息推送。这种分级通知机制的设计和实现,需要对业务场景有深刻理解,也需要扎实的技术功底。

困境四:数据可视化与决策支持

收到告警只是第一步,运营人员需要快速判断是否需要采取行动,以及采取什么行动。这就需要一个直观的可视化面板,能够展示当前状态、历史趋势、竞品对比等多维度信息。但大多数自建系统在这个环节力不从心——要么只有简单的数据表格,要么用Excel手工绘制图表,效率低下且容易出错。

一个完善的实时数据监控方案,应该提供实时刷新的仪表板,让运营人员一眼就能看到所有关键指标的状态。价格曲线、库存趋势、排名波动、评论增长,这些数据应该以图表的形式动态展示,并支持自定义时间范围、对比维度等交互功能。这种级别的可视化能力,往往需要专业的前端开发团队来实现。

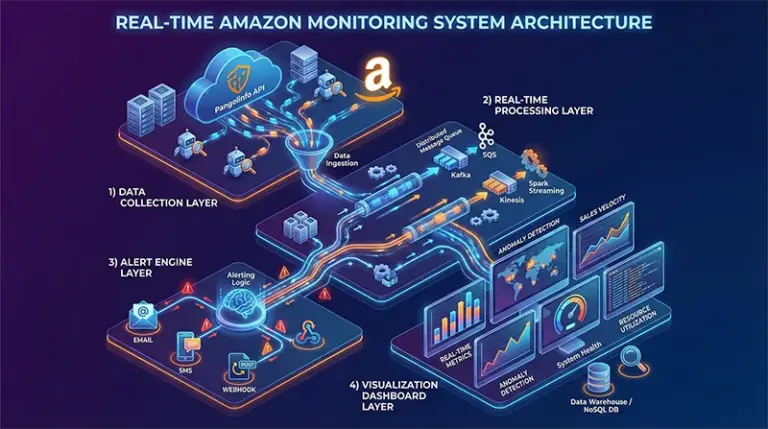

实时监控系统搭建的完整技术架构

一个企业级的亚马逊实时监控系统,应该由四个核心层次组成:数据采集层、实时处理层、告警引擎层和可视化展示层。每一层都有其特定的技术选型和实现要点,只有四层协同工作,才能构建出真正可靠的自动化监控系统。

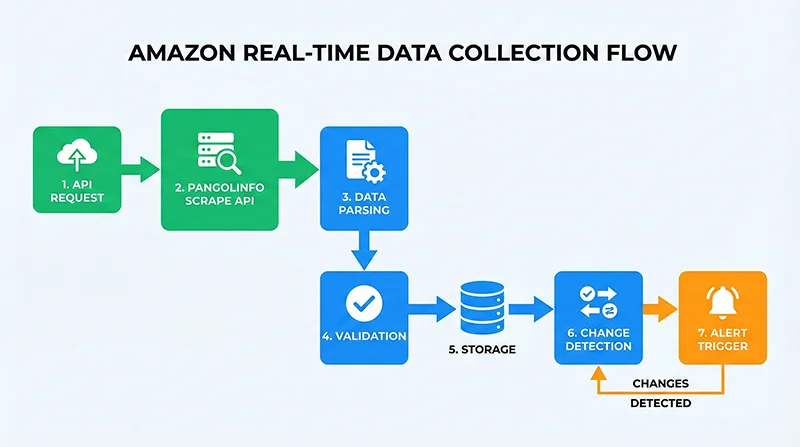

第一层:数据采集层 – 稳定高效的数据源

数据采集层是整个系统的基础。与其自己维护复杂的爬虫系统,不如选择专业的API服务。Pangolinfo Scrape API提供了稳定可靠的亚马逊数据采集能力,已经在底层解决了反爬虫对抗、数据解析、错误处理等技术难题。你只需要通过简单的HTTP请求,就能获得结构化的商品数据。

在数据采集频率设置上,需要根据业务需求和成本预算做平衡。对于核心竞品和自己的主推产品,可以设置为每5-10分钟采集一次;对于次要监控对象,每30分钟或1小时采集一次即可。通过任务队列(如Celery)来管理采集任务,可以实现灵活的频率控制和并发管理。

第二层:实时处理层 – 高效的数据流转

采集到的原始数据需要经过清洗、验证、存储等处理流程。这一层的关键是速度和可靠性。使用消息队列(RabbitMQ或Kafka)来解耦数据采集和处理,即使处理速度跟不上采集速度,也不会丢失数据。数据验证环节要检查必要字段的完整性,过滤掉异常数据,确保进入下游的都是高质量数据。

数据存储方案需要同时考虑实时查询和历史分析的需求。PostgreSQL或MySQL适合存储结构化的商品信息和历史记录,Redis则用于缓存最新数据和临时计算结果。合理的索引设计能大幅提升查询性能,分区表策略则能有效管理海量历史数据。

第三层:告警引擎层 – 智能的规则匹配

告警引擎是系统的大脑,负责将数据转化为可执行的告警信息。核心是一个灵活的规则引擎,支持配置各种复杂的告警条件。每当新数据到达,引擎会将其与历史数据对比,检查是否触发了任何告警规则。触发后,根据规则配置的优先级和通知渠道,将告警信息推送出去。

告警去重机制至关重要。如果竞品价格持续低于你的价格,你不希望每5分钟都收到一次告警。合理的策略是:首次触发时立即告警,之后如果状态未改变,则降低告警频率(如每小时提醒一次),或者只在状态恢复正常时再次通知。这种智能化的告警策略,能大幅减少告警疲劳。

第四层:可视化展示层 – 直观的数据呈现

可视化面板是运营人员与系统交互的界面。一个好的仪表板应该做到:关键指标一目了然,异常情况醒目提示,历史趋势清晰可见,交互操作流畅自然。使用React或Vue.js构建前端,ECharts或D3.js实现图表可视化,WebSocket实现数据的实时推送,能够打造出专业级的监控面板。

除了实时监控,系统还应该提供历史数据分析功能。运营人员可以查看任意时间段的价格曲线、库存变化、排名波动,进行竞品对比分析,发现市场规律。这些洞察能够支撑更科学的运营决策,而不是仅仅被动地响应告警。

亚马逊数据自动告警系统的代码实现

步骤一:搭建数据采集模块

首先,我们需要实现一个稳定的数据采集模块。以下是基于Pangolinfo API的Python实现示例:

import requests

import json

from datetime import datetime

from typing import Dict, List, Optional

class AmazonDataCollector:

"""亚马逊数据采集器"""

def __init__(self, api_key: str):

self.api_key = api_key

self.api_endpoint = "https://api.pangolinfo.com/scrape"

def collect_product_data(self, asin: str, domain: str = "amazon.com") -> Optional[Dict]:

"""

采集单个商品数据

Args:

asin: 商品ASIN

domain: 亚马逊站点域名

Returns:

商品数据字典,失败返回None

"""

params = {

"api_key": self.api_key,

"domain": domain,

"type": "product",

"asin": asin

}

try:

response = requests.get(self.api_endpoint, params=params, timeout=30)

response.raise_for_status()

data = response.json()

# 提取关键字段

product_data = {

"asin": asin,

"title": data.get("title"),

"price": data.get("price"),

"currency": data.get("currency"),

"availability": data.get("availability"),

"stock_level": data.get("stock_level"),

"rating": data.get("rating"),

"reviews_count": data.get("reviews_count"),

"rank": data.get("bestsellers_rank"),

"buybox_winner": data.get("buybox_winner"),

"timestamp": datetime.now().isoformat()

}

return product_data

except requests.exceptions.RequestException as e:

print(f"采集失败 {asin}: {str(e)}")

return None

def batch_collect(self, asin_list: List[str], domain: str = "amazon.com") -> List[Dict]:

"""

批量采集商品数据

Args:

asin_list: ASIN列表

domain: 亚马逊站点域名

Returns:

商品数据列表

"""

results = []

for asin in asin_list:

data = self.collect_product_data(asin, domain)

if data:

results.append(data)

return results

# 使用示例

collector = AmazonDataCollector(api_key="your_api_key_here")

# 监控的ASIN列表

monitor_asins = ["B08N5WRWNW", "B09G9FPHY6", "B0B7CPSN7R"]

# 采集数据

products_data = collector.batch_collect(monitor_asins)

print(f"成功采集 {len(products_data)} 个商品数据")

步骤二:实现变化检测与告警触发

采集到数据后,需要与历史数据对比,检测是否发生了需要告警的变化:

from typing import Dict, List, Optional

import psycopg2

from decimal import Decimal

class ChangeDetector:

"""变化检测器"""

def __init__(self, db_config: Dict):

self.conn = psycopg2.connect(**db_config)

def get_latest_data(self, asin: str) -> Optional[Dict]:

"""获取ASIN的最新历史数据"""

cursor = self.conn.cursor()

cursor.execute("""

SELECT price, stock_level, rank, reviews_count

FROM product_history

WHERE asin = %s

ORDER BY timestamp DESC

LIMIT 1

""", (asin,))

row = cursor.fetchone()

cursor.close()

if row:

return {

"price": row[0],

"stock_level": row[1],

"rank": row[2],

"reviews_count": row[3]

}

return None

def detect_changes(self, current_data: Dict, historical_data: Optional[Dict]) -> List[Dict]:

"""

检测数据变化

Returns:

变化列表,每个变化包含type和details

"""

if not historical_data:

return [] # 首次采集,无历史数据

changes = []

# 价格变化检测

if current_data.get("price") and historical_data.get("price"):

current_price = Decimal(str(current_data["price"]))

historical_price = Decimal(str(historical_data["price"]))

if current_price != historical_price:

change_percent = ((current_price - historical_price) / historical_price) * 100

changes.append({

"type": "price_change",

"asin": current_data["asin"],

"old_value": float(historical_price),

"new_value": float(current_price),

"change_percent": float(change_percent),

"direction": "increase" if current_price > historical_price else "decrease"

})

# 库存变化检测

if current_data.get("stock_level") and historical_data.get("stock_level"):

if current_data["stock_level"] != historical_data["stock_level"]:

changes.append({

"type": "stock_change",

"asin": current_data["asin"],

"old_value": historical_data["stock_level"],

"new_value": current_data["stock_level"]

})

# 排名变化检测

if current_data.get("rank") and historical_data.get("rank"):

rank_change = current_data["rank"] - historical_data["rank"]

if abs(rank_change) >= 10: # 排名变化超过10位才告警

changes.append({

"type": "rank_change",

"asin": current_data["asin"],

"old_value": historical_data["rank"],

"new_value": current_data["rank"],

"change": rank_change

})

return changes

def save_data(self, data: Dict):

"""保存数据到数据库"""

cursor = self.conn.cursor()

cursor.execute("""

INSERT INTO product_history

(asin, title, price, currency, stock_level, rating, reviews_count, rank, timestamp)

VALUES (%s, %s, %s, %s, %s, %s, %s, %s, %s)

""", (

data["asin"], data["title"], data["price"], data["currency"],

data["stock_level"], data["rating"], data["reviews_count"],

data["rank"], data["timestamp"]

))

self.conn.commit()

cursor.close()

# 使用示例

db_config = {

"host": "localhost",

"database": "amazon_monitor",

"user": "your_user",

"password": "your_password"

}

detector = ChangeDetector(db_config)

for product in products_data:

# 获取历史数据

historical = detector.get_latest_data(product["asin"])

# 检测变化

changes = detector.detect_changes(product, historical)

# 保存新数据

detector.save_data(product)

# 如果有变化,触发告警

if changes:

print(f"检测到变化: {changes}")

步骤三:配置告警规则与多渠道通知

实现一个灵活的告警引擎,支持多种通知渠道:

import smtplib

from email.mime.text import MIMEText

from email.mime.multipart import MIMEMultipart

import requests

from typing import Dict, List

class AlertEngine:

"""告警引擎"""

def __init__(self, config: Dict):

self.config = config

self.alert_rules = self.load_alert_rules()

def load_alert_rules(self) -> List[Dict]:

"""加载告警规则"""

return [

{

"name": "竞品大幅降价",

"condition": lambda change: (

change["type"] == "price_change" and

change["direction"] == "decrease" and

abs(change["change_percent"]) >= 10

),

"priority": "high",

"channels": ["email", "sms", "webhook"]

},

{

"name": "库存告急",

"condition": lambda change: (

change["type"] == "stock_change" and

change["new_value"] < 10

),

"priority": "medium",

"channels": ["email", "webhook"]

},

{

"name": "排名大幅下降",

"condition": lambda change: (

change["type"] == "rank_change" and

change["change"] > 20

),

"priority": "medium",

"channels": ["email"]

}

]

def match_rules(self, change: Dict) -> List[Dict]:

"""匹配告警规则"""

matched_rules = []

for rule in self.alert_rules:

if rule["condition"](change):

matched_rules.append(rule)

return matched_rules

def send_email(self, subject: str, body: str, to_email: str):

"""发送邮件告警"""

msg = MIMEMultipart()

msg['From'] = self.config["email"]["from"]

msg['To'] = to_email

msg['Subject'] = subject

msg.attach(MIMEText(body, 'html'))

try:

server = smtplib.SMTP(self.config["email"]["smtp_host"],

self.config["email"]["smtp_port"])

server.starttls()

server.login(self.config["email"]["username"],

self.config["email"]["password"])

server.send_message(msg)

server.quit()

print(f"邮件告警已发送: {subject}")

except Exception as e:

print(f"邮件发送失败: {str(e)}")

def send_webhook(self, data: Dict, webhook_url: str):

"""发送WebHook通知"""

try:

response = requests.post(webhook_url, json=data, timeout=10)

response.raise_for_status()

print(f"WebHook通知已发送")

except Exception as e:

print(f"WebHook发送失败: {str(e)}")

def trigger_alert(self, change: Dict, rules: List[Dict]):

"""触发告警"""

for rule in rules:

# 构造告警消息

if change["type"] == "price_change":

subject = f"价格告警: {change['asin']}"

body = f"""

价格变化告警

ASIN: {change['asin']}

原价: ${change['old_value']:.2f}

现价: ${change['new_value']:.2f}

变化: {change['change_percent']:.1f}%

时间: {datetime.now().strftime('%Y-%m-%d %H:%M:%S')}

"""

elif change["type"] == "stock_change":

subject = f"库存告警: {change['asin']}"

body = f"""

库存变化告警

ASIN: {change['asin']}

原库存: {change['old_value']}

现库存: {change['new_value']}

时间: {datetime.now().strftime('%Y-%m-%d %H:%M:%S')}

"""

else:

subject = f"告警: {change['asin']}"

body = f"检测到变化: {change}"

# 根据配置的渠道发送通知

if "email" in rule["channels"]:

self.send_email(subject, body, self.config["alert_email"])

if "webhook" in rule["channels"] and self.config.get("webhook_url"):

webhook_data = {

"alert_type": change["type"],

"asin": change["asin"],

"details": change,

"priority": rule["priority"]

}

self.send_webhook(webhook_data, self.config["webhook_url"])

# 使用示例

alert_config = {

"email": {

"from": "[email protected]",

"smtp_host": "smtp.gmail.com",

"smtp_port": 587,

"username": "[email protected]",

"password": "your_password"

},

"alert_email": "[email protected]",

"webhook_url": "https://hooks.slack.com/services/YOUR/WEBHOOK/URL"

}

alert_engine = AlertEngine(alert_config)

# 处理检测到的变化

for change in changes:

matched_rules = alert_engine.match_rules(change)

if matched_rules:

alert_engine.trigger_alert(change, matched_rules)

步骤四:使用Celery实现定时任务调度

为了实现真正的实时监控,我们需要定时执行采集任务。Celery是Python中最流行的分布式任务队列:

from celery import Celery

from celery.schedules import crontab

import redis

# 初始化Celery

app = Celery('amazon_monitor', broker='redis://localhost:6379/0')

# 配置定时任务

app.conf.beat_schedule = {

'monitor-high-priority-products': {

'task': 'tasks.monitor_products',

'schedule': 300.0, # 每5分钟执行一次

'args': (['B08N5WRWNW', 'B09G9FPHY6'], 'high')

},

'monitor-normal-products': {

'task': 'tasks.monitor_products',

'schedule': 1800.0, # 每30分钟执行一次

'args': (['B0B7CPSN7R', 'B08CFSZLQ4'], 'normal')

},

}

@app.task

def monitor_products(asin_list, priority):

"""监控商品任务"""

print(f"开始监控 {priority} 优先级商品: {asin_list}")

# 采集数据

collector = AmazonDataCollector(api_key="your_api_key")

products_data = collector.batch_collect(asin_list)

# 检测变化并告警

detector = ChangeDetector(db_config)

alert_engine = AlertEngine(alert_config)

for product in products_data:

historical = detector.get_latest_data(product["asin"])

changes = detector.detect_changes(product, historical)

detector.save_data(product)

if changes:

for change in changes:

matched_rules = alert_engine.match_rules(change)

if matched_rules:

alert_engine.trigger_alert(change, matched_rules)

print(f"监控完成: {len(products_data)} 个商品")

return len(products_data)

# 启动Celery Worker: celery -A tasks worker --loglevel=info

# 启动Celery Beat: celery -A tasks beat --loglevel=info

完整的代码示例和更多技术细节,请访问Pangolinfo文档中心。

WebHook集成:打通第三方协作工具

WebHook是实现系统间实时通信的标准方式。通过WebHook,你可以将告警信息推送到Slack、Discord、企业微信等协作工具,也可以触发其他自动化流程。以下是Slack WebHook集成的完整示例:

def send_slack_alert(webhook_url: str, change: Dict):

"""发送Slack告警"""

# 根据变化类型构造不同的消息

if change["type"] == "price_change":

color = "danger" if change["direction"] == "decrease" else "good"

emoji = "📉" if change["direction"] == "decrease" else "📈"

payload = {

"text": f"{emoji} 价格变化告警",

"attachments": [{

"color": color,

"fields": [

{

"title": "ASIN",

"value": change["asin"],

"short": True

},

{

"title": "变化幅度",

"value": f"{change['change_percent']:.1f}%",

"short": True

},

{

"title": "原价",

"value": f"${change['old_value']:.2f}",

"short": True

},

{

"title": "现价",

"value": f"${change['new_value']:.2f}",

"short": True

}

],

"footer": "Amazon Monitor",

"ts": int(datetime.now().timestamp())

}]

}

response = requests.post(webhook_url, json=payload)

return response.status_code == 200

通过这种方式,运营团队可以在Slack频道中实时接收告警,快速讨论并采取行动,大大提升响应效率。

可视化监控面板:让数据一目了然

一个直观的可视化面板能让运营人员快速掌握全局。使用Flask构建后端API,React+ECharts构建前端,可以实现专业级的监控仪表板。以下是后端API的核心代码:

from flask import Flask, jsonify, request

from flask_cors import CORS

import psycopg2

app = Flask(__name__)

CORS(app)

@app.route('/api/dashboard/summary', methods=['GET'])

def get_dashboard_summary():

"""获取仪表板摘要数据"""

conn = psycopg2.connect(**db_config)

cursor = conn.cursor()

# 获取最新的监控数据

cursor.execute("""

SELECT

COUNT(DISTINCT asin) as total_products,

AVG(price) as avg_price,

SUM(CASE WHEN stock_level < 10 THEN 1 ELSE 0 END) as low_stock_count

FROM product_history

WHERE timestamp > NOW() - INTERVAL '1 hour'

""")

row = cursor.fetchone()

summary = {

"total_products": row[0],

"average_price": float(row[1]) if row[1] else 0,

"low_stock_products": row[2]

}

cursor.close()

conn.close()

return jsonify(summary)

@app.route('/api/product/history', methods=['GET'])

def get_product_history():

"""获取商品历史数据"""

asin = request.args.get('asin')

hours = int(request.args.get('hours', 24))

conn = psycopg2.connect(**db_config)

cursor = conn.cursor()

cursor.execute("""

SELECT timestamp, price, stock_level, rank

FROM product_history

WHERE asin = %s AND timestamp > NOW() - INTERVAL '%s hours'

ORDER BY timestamp ASC

""", (asin, hours))

rows = cursor.fetchall()

history = {

"timestamps": [row[0].isoformat() for row in rows],

"prices": [float(row[1]) if row[1] else None for row in rows],

"stock_levels": [row[2] for row in rows],

"ranks": [row[3] for row in rows]

}

cursor.close()

conn.close()

return jsonify(history)

if __name__ == '__main__':

app.run(debug=True, port=5000)

前端可以使用ECharts绘制实时更新的折线图,展示价格和库存的变化趋势。配合WebSocket实现数据的实时推送,用户无需刷新页面就能看到最新数据。

实时数据监控方案的最佳实践

采集频率优化策略

不同的商品和场景需要不同的采集频率。建议采用分级策略:核心竞品每5分钟采集一次,重要关注对象每15分钟一次,一般监控对象每小时一次。在促销期间(如Prime Day、黑五),可以临时提高采集频率。使用动态调整机制,当检测到异常变化时,自动提高该ASIN的采集频率,持续观察一段时间后再恢复正常。

告警规则配置技巧

避免告警疲劳是配置规则的关键。设置合理的阈值,不要对微小变化过度敏感。使用告警聚合,将短时间内的多次相似告警合并为一条。实施告警静默期,同一类型的告警在一定时间内只发送一次。根据业务重要性设置优先级,紧急告警用高优先级渠道(短信、电话),普通告警用低优先级渠道(邮件、Slack)。

系统稳定性保障

实时监控系统需要7×24小时稳定运行。使用Docker容器化部署,便于扩展和迁移。配置进程监控(如Supervisor),自动重启崩溃的服务。设置系统自监控,当采集失败率超过阈值时,向管理员发送告警。定期备份数据库,防止数据丢失。使用负载均衡,在高并发场景下保证性能。

成本控制建议

API调用是主要成本来源。通过合理的采集频率设置,可以在保证实时性的同时控制成本。使用缓存机制,避免重复采集相同数据。对于不常变化的字段(如商品标题、图片),可以降低采集频率。选择合适的服务器配置,避免过度配置造成浪费。使用Pangolinfo控制台的用量监控功能,实时掌握API调用情况。

从被动响应到主动掌控:实时监控的战略价值

在亚马逊这个瞬息万变的战场上,信息时效性就是竞争力。当你的竞品还在用每天一次的监控工具时,你已经能在5分钟内感知市场变化并快速响应。这种时间优势,会在长期竞争中转化为巨大的商业价值——更高的销量、更好的利润率、更稳定的市场地位。

实时监控系统搭建不是一次性的技术项目,而是一个持续优化的过程。从最基础的价格库存变化通知开始,逐步扩展到排名监控、评论追踪、竞品分析等更多维度。随着业务的发展,你的监控系统也会不断进化,成为运营决策的核心支撑。

Pangolinfo Scrape API为你提供了可靠的数据基础,剩下的就是将这些数据转化为可执行的洞察。无论你是技术团队自建系统,还是产品经理设计监控功能,本文提供的完整方案都能帮助你快速起步。从今天开始,构建属于你的亚马逊数据自动告警系统,在竞争中抢占先机。

立即开始构建你的实时监控系统

访问 Pangolinfo Scrape API 了解更多详情,或直接在控制台注册免费试用。专业的技术支持团队随时为你解答疑问,帮助你快速搭建企业级监控平台。

完整的API文档、代码示例和最佳实践,请访问Pangolinfo文档中心。

在亚马逊的竞争中,时间就是金钱。不要让延迟的信息拖累你的决策——现在就行动,用实时数据照亮前路。